时间:2025-05-16 关注公众号 来源:网络

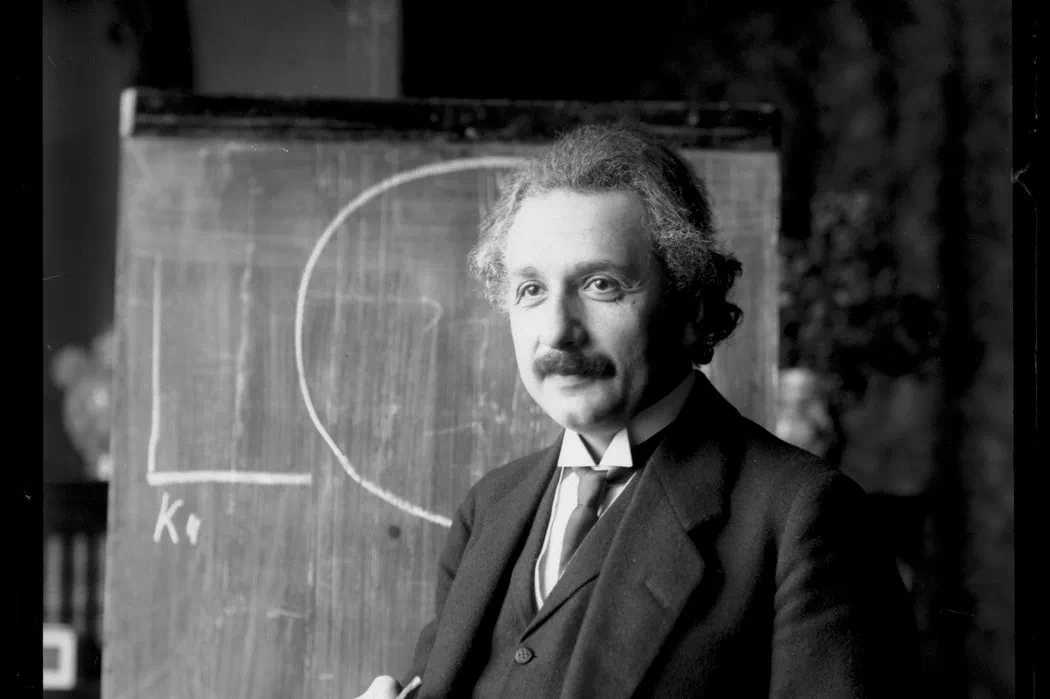

在人工智能领域的一次重大飞跃中,科技巨头英伟达推出了最新的视觉语言模型——鹰眼2.5。这款革命性的模型不仅是技术精度的象征,更是跨入智能视觉时代的重要一步。鹰眼2.5以其卓越的处理能力,能够理解并解析复杂的视觉信息,同时与语言文字无缝对接,开创了人机交互的新纪元。它不仅在图像识别、自然语言处理上达到了前所未有的水平,还在自动驾驶、医疗影像分析、虚拟现实等众多领域展现出了巨大潜力。英伟达的这一创新之作,标志着我们距离实现全场景智能化更近了一步,为科研、工业和日常生活带来了无限可能。

eagle2.5是由英伟达推出的一款专注于长上下文多模态学习的视觉语言模型,拥有8b的参数规模。尽管参数量较小,但其在处理高分辨率图像和长视频序列方面表现出色,性能与参数量更大的qwen2.5-vl-72b和internvl2.5-78b不相上下。eagle2.5采用了创新的训练策略,包括信息优先采样和渐进式后训练。信息优先采样通过图像区域保留和自动降级采样技术,确保图像的完整性和视觉细节的优化。渐进式后训练则通过逐步扩展上下文窗口,使模型在不同输入长度下保持稳定性能。

Eagle2.5的主要功能包括:

Eagle2.5的主要功能包括:

Eagle2.5的技术原理包括:

信息优先采样(Information-FirstSampling):Eagle2.5采用图像区域保留(IAP)技术,保留超过60%的原始图像区域,同时减少宽高比失真。自动降级采样(ADS)技术根据上下文长度动态平衡视觉和文本输入,确保文本的完整性和视觉细节的优化。 渐进式后训练(ProgressivePost-Training):通过逐步扩展模型的上下文窗口,从32K到128Ktoken,使模型在不同输入长度下保持稳定性能,避免过拟合单一上下文范围,确保了模型在多样化任务中的灵活性。 定制化数据集:Eagle2.5使用了专为长视频理解设计的定制数据集Eagle-Video-110K。数据集采用双重标注方式,自上而下的方法结合故事级分割和人类标注的章节元数据,自下而上的方法则利用GPT-4o为短片段生成问答对。通过余弦相似度筛选,数据集强调多样性而非冗余,确保了叙事连贯性和细粒度标注。 视觉编码与投影层:Eagle2.5结合了SigLIP视觉编码和MLP投影层,用于对齐视觉嵌入与语言模型表示空间,增强了模型在多样化任务中的灵活性和适应性。Eagle2.5的项目地址包括:

项目官网: arXiv技术论文:Eagle2.5的应用场景包括:

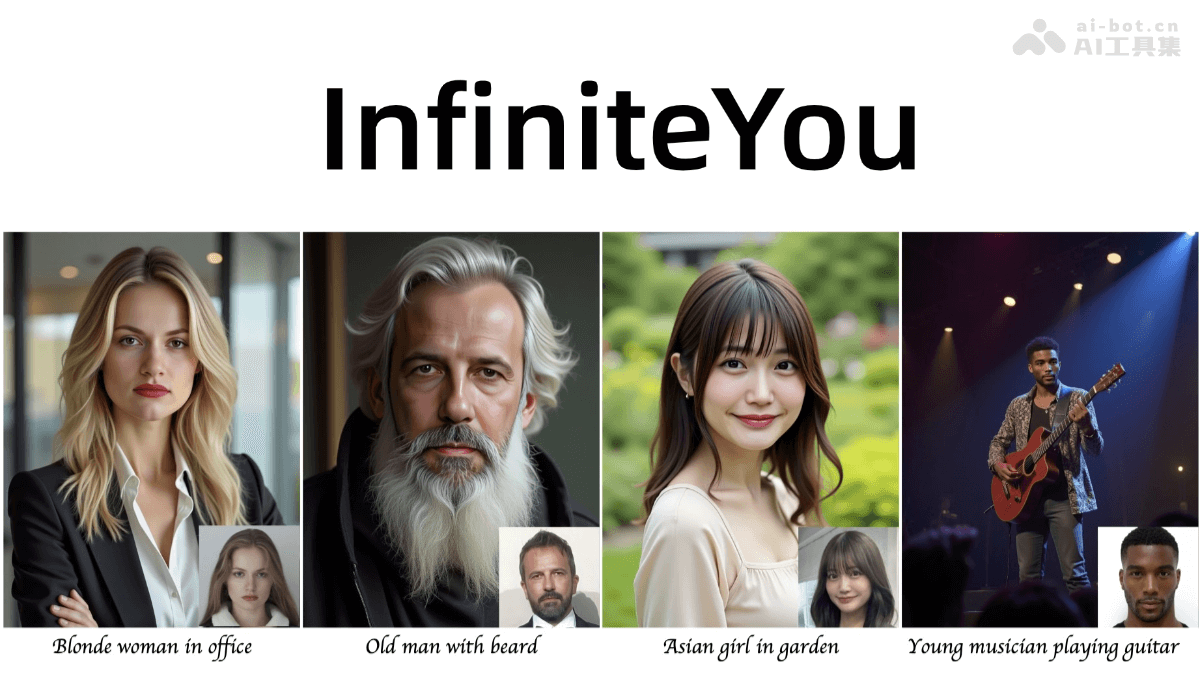

智能视频分析:Eagle2.5擅长处理长视频序列,能理解和生成与视频内容相关的文本描述。在监控系统中,可以实时分析视频流,检测异常行为并生成警报信息。 高分辨率图像处理:Eagle2.5在处理高分辨率图像时表现出色,能进行图像分类、目标检测以及图像描述生成。 内容创作与营销:Eagle2.5可以生成高质量的图像描述和视频脚本,适用于广告、社交媒体内容创作等领域。 教育与培训:在教育领域,Eagle2.5可以生成与教学视频或图像相关的解释性文本,帮助学生更好地理解复杂概念。 自动驾驶与机器人:Eagle2.5的多模态理解能力能处理来自摄像头的视觉数据,结合文本指令进行决策。以上就是Eagle2.5—英伟达推出的视觉语言模型的详细内容,更多请关注其它相关文章!