时间:2025-05-16 关注公众号 来源:网络

在即将到来的2025年国际会议 on Learning Representations (ICLR)上,来自哈尔滨工业大学深圳研究生院的张正团队将揭开他们的最新研究成果——PolaFormer。这一创新工作挑战了传统视觉基础模型的界限,通过引入极性感知的概念,彻底革新了线性注意力机制的理解与应用。PolaFormer不仅优化了计算效率,更在保持高性能的同时,揭示了数据中隐藏的极性特征对于视觉任务的关键作用。该模型的提出,预示着计算机视觉领域将迎来一个全新的视角,可能颠覆现有的图像处理和理解方式,为未来人工智能的视觉系统奠定了更为坚实和智能的基础。这项研究不仅技术精湛,其潜在的应用范围,从自动驾驶到医疗影像分析,都让人充满期待,标志着我们向更加智能、敏感的人工视觉系统迈出了重要一步。

polaformer:一种极性感知线性注意力机制,赋能高效视觉transformer

AIxiv专栏持续报道全球顶尖AI研究成果,本文介绍哈尔滨工业大学(深圳)与鹏城实验室联合培养博士生孟维康及其导师张正教授团队的最新研究:PolaFormer。该研究提出了一种新型的极性感知线性注意力机制,有效提升了视觉Transformer的性能和计算效率。

研究背景:视觉Transformer的效率瓶颈

VisionTransformer及其变体在视觉任务中表现出色,但其自注意力机制的二次方复杂度限制了其在处理长序列或高分辨率图像时的效率。线性注意力机制通过替代softmax函数来降低复杂度,但现有方法存在不足:忽略负值信息,导致注意力权重分布信息熵过高。

PolaFormer的创新之处:极性感知与信息熵控制

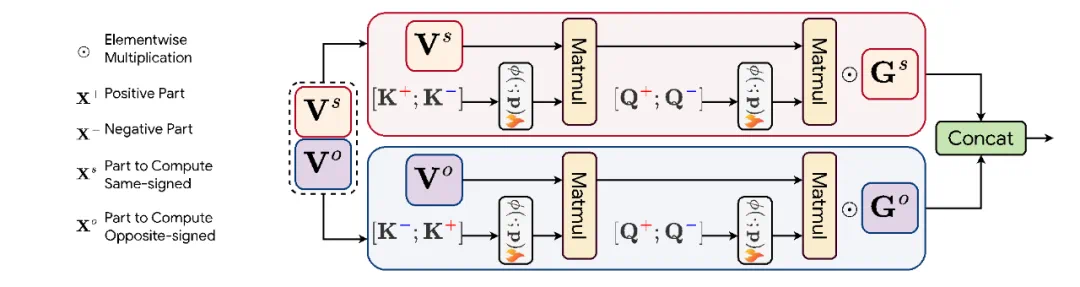

PolaFormer巧妙地解决了以上问题。它首先提出极性感知线性注意力,将查询向量(query)和键向量(key)分解为正负部分,分别计算正负相似度,避免了现有方法忽略负值信息的缺陷,从而更准确地捕捉特征间的关联。

其次,PolaFormer利用可学习的幂函数来降低注意力权重分布的信息熵,并通过数学证明支撑了该方法的有效性。这使得模型能够更有效地区分重要特征,提升性能。

实验结果:显著性能提升

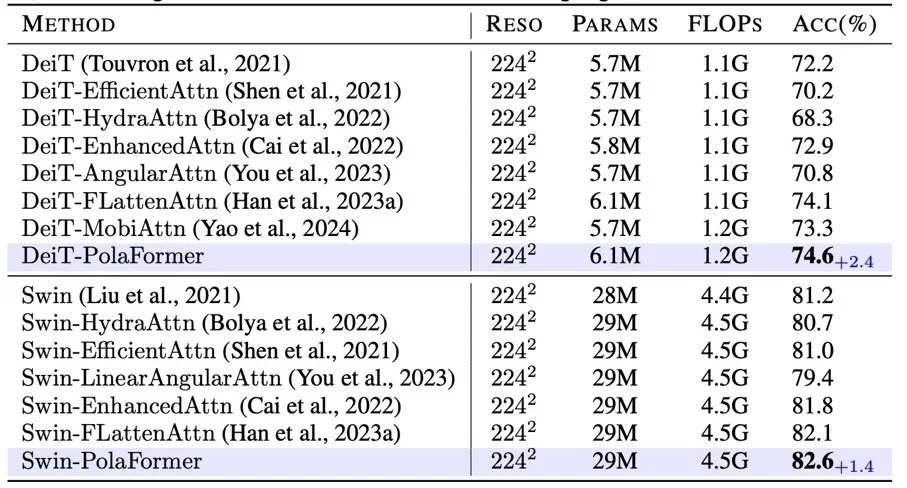

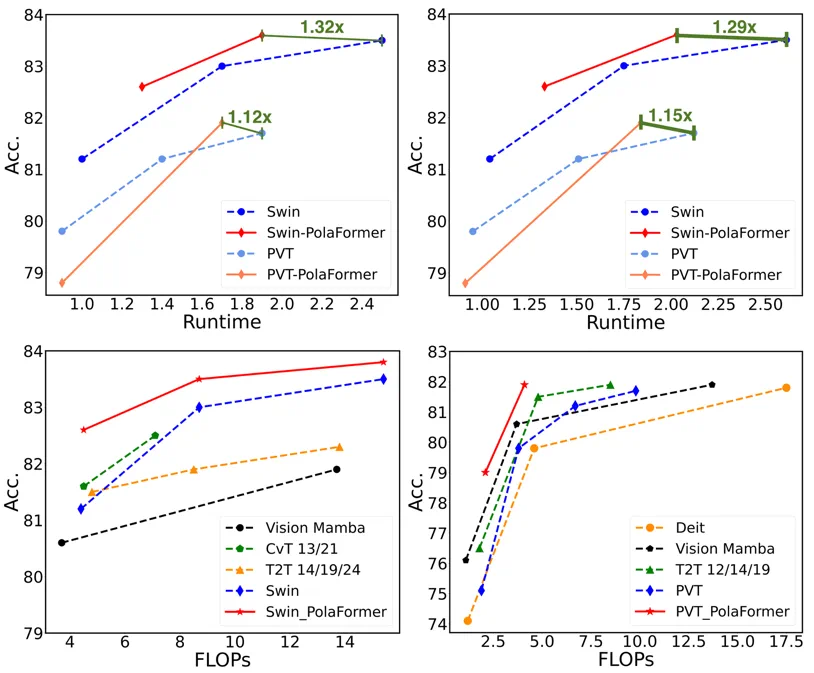

在图像分类、目标检测、实例分割和语义分割等视觉任务以及LRA任务上,PolaFormer均取得了显著的性能提升,证明了其有效性。

论文及代码:

论文标题:PolaFormer:Polarity-awareLinearAttentionforVisionTransformers 论文链接: GitHub链接: Huggingface权重链接:团队信息:

第一作者:孟维康(哈尔滨工业大学(深圳)与鹏城实验室联合培养博士生) 通讯作者:张正教授(哈尔滨工业大学(深圳)长聘教授) 课题组:BigMediaIntelligence(BMI)PolaFormer为高效视觉Transformer的研究提供了新的思路,其在提升计算效率的同时,也显著提高了模型性能,具有重要的学术价值和应用前景。欢迎感兴趣的读者访问相关链接了解更多细节。

以上就是ICLR2025|极性感知线性注意力!哈工深张正团队提出PolaFormer视觉基础模型的详细内容,更多请关注其它相关文章!