时间:2025-05-16 关注公众号 来源:网络

在人工智能的浩瀚领域,英伟达始终站在技术创新的最前沿。近日,这家公司再度引发行业震动,隆重推出了Nemotron Llama系列推理模型。这一系列模型代表了英伟达在高效推理技术上的重大突破,旨在为人工智能应用提供更为强大、快速且精准的计算支持。Nemotron Llama系列不仅继承了英伟达在GPU加速计算的深厚底蕴,更是在模型优化、能效比提升上迈出了关键一步,为机器学习的边缘计算和云端服务带来了革命性的变化。通过深度融合算法与硬件的创新,Nemotron Llama系列正引领着AI推理技术进入一个新时代,其在图像识别、自然语言处理等领域的应用潜力,预示着未来智能应用将更加广泛且智能。这不仅是技术的跃进,更是推动各行业智能化转型的强大动力。

NVIDIA发布的llamanemotron系列推理模型,旨在提升多种智能代理任务的推理能力。该模型基于llama开源模型,并经过nvidia的二次训练,强化了其在科学推理、高级数学、编程、指令遵循和工具调用等方面的能力。llamanemotron家族包含nano、Super和ultra三个版本,分别针对不同硬件和应用场景进行优化。

Nano版本(llama-3.1-nemotron-nano-8b-v1),基于Llama3.18B模型微调,适用于PC和边缘设备。Super版本(llama-3.3-nemotron-super-49b-v1),源于Llama3.370B模型蒸馏,针对数据中心GPU优化,兼顾高吞吐量和准确性。Ultra版本(Llama-3.1-Nemotron-Ultra-253B-v1),基于Llama3.1405B模型蒸馏,专为多GPU数据中心设计,性能在多个基准测试中与DeepSeekR1相当,甚至超越了Meta最新的Llama4Behemoth和Llama4Maverick。

LlamaNemotron的核心功能:

强大的推理能力:高效处理复杂的逻辑推理、数学问题求解和多步骤问题。 多任务处理:支持数学、编程、指令遵循及函数调用等多种任务,并可通过系统提示词灵活切换模式。 高效对话:生成高质量、流畅自然的对话内容,适用于聊天机器人等应用。 高效计算与优化:采用神经架构搜索(NAS)和知识蒸馏技术,降低内存占用,提升推理速度和效率。 多智能体协作:支持多智能体协作,实现信息共享、反馈和修正,从而更高效地解决复杂问题。LlamaNemotron的技术架构:

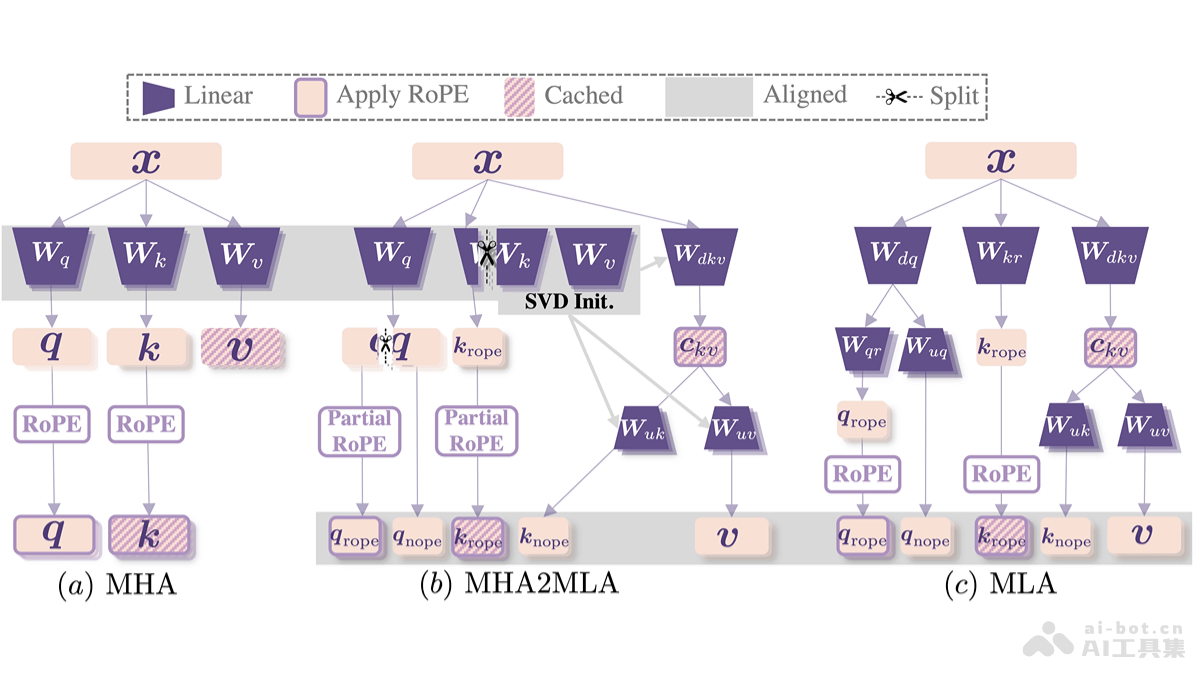

LlamaNemotron在Llama开源模型基础上,通过以下技术手段增强了其能力:

Llama模型改进:在Llama模型架构上进行进一步训练和优化,提升推理和多任务处理能力。 神经架构搜索(NAS):优化模型架构,使其更适应特定硬件,减少参数量,提高计算效率。 知识蒸馏:将大型模型的知识迁移到较小模型,减小模型体积,同时保持或提升性能。 监督微调:利用高质量的合成数据和真实数据进行监督微调,确保模型输出质量。 强化学习:运用强化学习(RL)和人类反馈强化学习(RLHF)技术,提升对话能力和指令遵循能力,使其更符合用户预期。 推理阶段扩展:在推理阶段动态增加计算资源,通过多步骤思考和验证,提升复杂任务处理能力。 系统提示词控制:利用系统提示词控制推理模式的启用和禁用,灵活适应不同任务需求。项目信息:

项目官网: HuggingFace模型库:应用领域:

LlamaNemotron的应用范围广泛,包括:

复杂问题求解:解决高难度数学题、逻辑推理和多步骤问题,应用于科学研究和教育领域。 智能客服:提供高效、准确的多语言客户支持,提升用户体验。 医疗辅助:辅助医生诊断和治疗规划,支持医疗研究和报告撰写。 物流优化:优化物流路径和库存管理,提升供应链效率。 金融分析:预测市场趋势,评估投资风险,辅助金融决策。以上就是LlamaNemotron—英伟达推出的系列推理模型的详细内容,更多请关注其它相关文章!