时间:2025-05-16 关注公众号 来源:网络

在人工智能的浩瀚疆域中,阿里巴巴推出了一项里程碑式的技术成果——Qwen 2.5-Omni,这一开源模型标志着我们向全面智能迈出了坚实的一步。Qwen 2.5-Omni是一个革命性的端到端多模态学习框架,它巧妙地融合了文本、图像乃至更多模态的信息处理能力,旨在解决复杂应用场景下的理解和生成任务。通过深度学习的魔力,该模型能够理解人类语言的细微差别,同时解读视觉信息,实现知识的跨模态桥梁搭建。这一创举不仅提升了AI在教育、医疗、媒体等领域的应用潜能,还为研究人员提供了一个强大的工具箱,共同探索多模态智能的无限可能。阿里巴巴的这次开源,不仅是技术的共享,更是推动全球AI研究和应用普惠进步的一大步。

阿里巴巴开源的qwen2.5-omni:一款70亿参数的旗舰级多模态模型

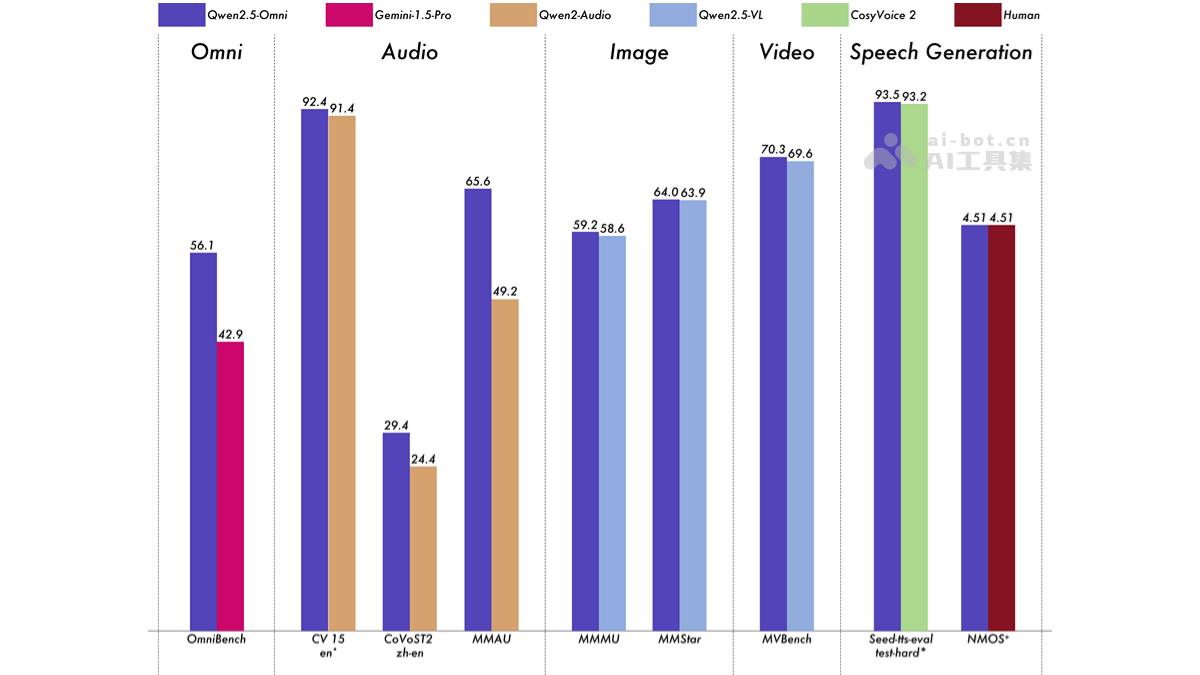

Qwen2.5-Omni是阿里云最新发布的开源多模态大型语言模型,拥有70亿参数,在多模态任务中表现卓越,全面超越了GoogleGemini1.5-Pro等同类模型。它能够处理文本、图像、音频和视频等多种模态信息,并支持流式文本生成和自然语音合成,实现实时语音及视频聊天功能。

核心功能:

Qwen2.5-Omni具备以下关键能力:

全模态理解与生成:精通文本处理,支持多种语言;具备图像识别、音频处理(语音识别及合成)和视频理解能力。 实时交互:支持流畅的实时语音和视频聊天。技术架构与创新:

该模型采用独特的Thinker-Talker架构,Thinker负责多模态信息理解和高级语义表示生成,Talker则负责将这些表示转化为流畅的语音输出。为了高效处理多模态信息,特别是时间序列数据,Qwen2.5-Omni引入了时间对齐多模态位置嵌入(TMRoPE)技术,巧妙地处理音频和视频数据的时间同步问题。此外,它还采用块状处理和滑动窗口机制,实现高效的流式处理和实时响应。模型训练分三个阶段进行,逐步提升其多模态理解和长序列处理能力。

资源与访问:

项目官网: GitHub: HuggingFace: 在线Demo:性能表现:

Qwen2.5-Omni在OmniBench等多模态基准测试中取得了领先地位,并在语音识别、翻译、音频理解、图像推理和视频理解等单模态任务上也表现出色。

应用前景:

Qwen2.5-Omni的应用场景广泛,包括:

智能客服与虚拟助手:提供更自然、更智能的交互体验。 在线教育:增强教学互动性和趣味性。 娱乐领域:提升游戏和视频的沉浸感。 智能办公:提高工作效率。Qwen2.5-Omni的开源和免费商用特性,将极大推动多模态人工智能技术的普及和应用。

以上就是Qwen2.5-Omni—阿里开源的端到端多模态模型的详细内容,更多请关注其它相关文章!