时间:2025-05-19 关注公众号 来源:网络

在不远的未来,编程的边界被一枚名为aiXcoder-7B的代码巨匠悄然打破。这不仅是一部科技的史诗,更是一次智慧的飞跃。北京大学的aixcoder团队,如同现代的炼金术士,将冰冷的代码与深奥的抽象语法树融合,于icse2025的璀璨舞台上,揭开这一革命性成果的神秘面纱。

故事发生在数字编织的海洋,主角是一位与时间赛跑的软件工程师,李晨光。他面临着一个看似不可能完成的项目,直到他遇见了aiXcoder-7B——这不仅仅是一个工具,而是一位理解代码之魂的伙伴。在渥太华的春日里,随着技术的光芒照亮李晨光的屏幕,代码仿佛拥有了生命,跨越文件间的鸿沟,以前所未有的方式自动生成,解决了一个又一个编程难题。

但这只是开始。aiXcoder-7B的出现,不仅让李晨光的项目柳暗花明,更引发了一场关于人工智能与人类创造力界限的深刻探讨。在这场科技风暴中,李晨光与他的AI伙伴,共同探索着编程艺术的新维度,挑战着软件工程的极限。他们是否能解开编程世界的终极秘密,创造出让世界瞩目的奇迹?这是一段关于技术梦想、人机协作与未知探索的精彩旅程,等待着每一个对代码世界充满好奇的心去发现。

北京大学aixcoder团队的代码大模型aixcoder-7b,在软件工程领域顶级会议icse2025上发表论文,并将于4月27日至5月3日在加拿大渥太华分享研究成果。该模型将抽象语法树(ast)结构与大规模预训练相结合,提升了对代码结构和上下文的理解能力,并在企业应用中获得广泛认可。

代码大模型训练的挑战与aiXcoder-7B的创新

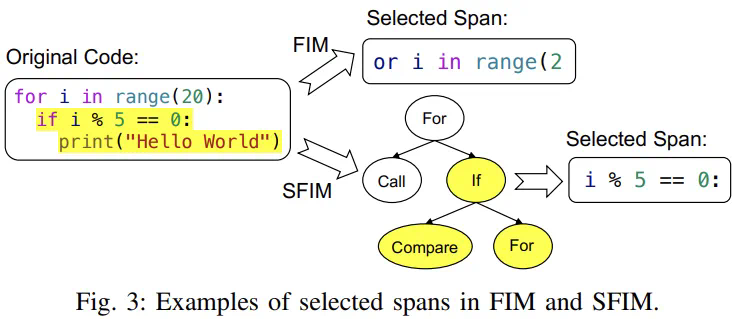

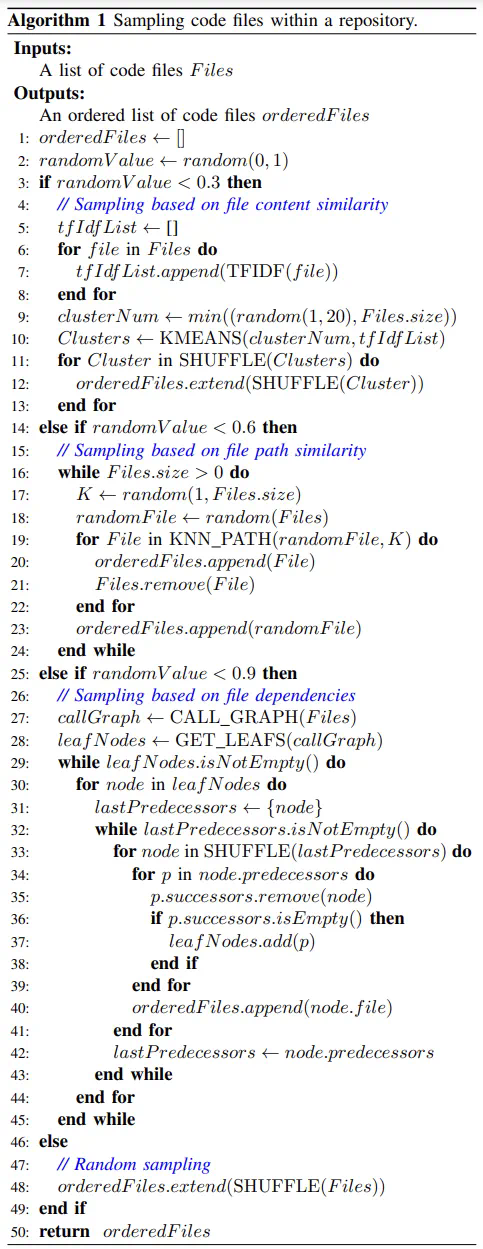

训练代码大模型看似简单,但实际需要从实际开发场景出发。现有模型常将代码视为自然语言文本,忽略了代码的结构性和上下文关系。aiXcoder-7B则创新性地将软件工程方法融入大规模预训练中,主要体现在以下几个方面:

数据预处理:利用软件工程工具,确保代码数据语法正确,并去除Bug、漏洞和敏感信息。这包括语法分析和静态分析,分别检测语法错误和潜在的运行时错误。

aiXcoder-7B的优势与未来方向

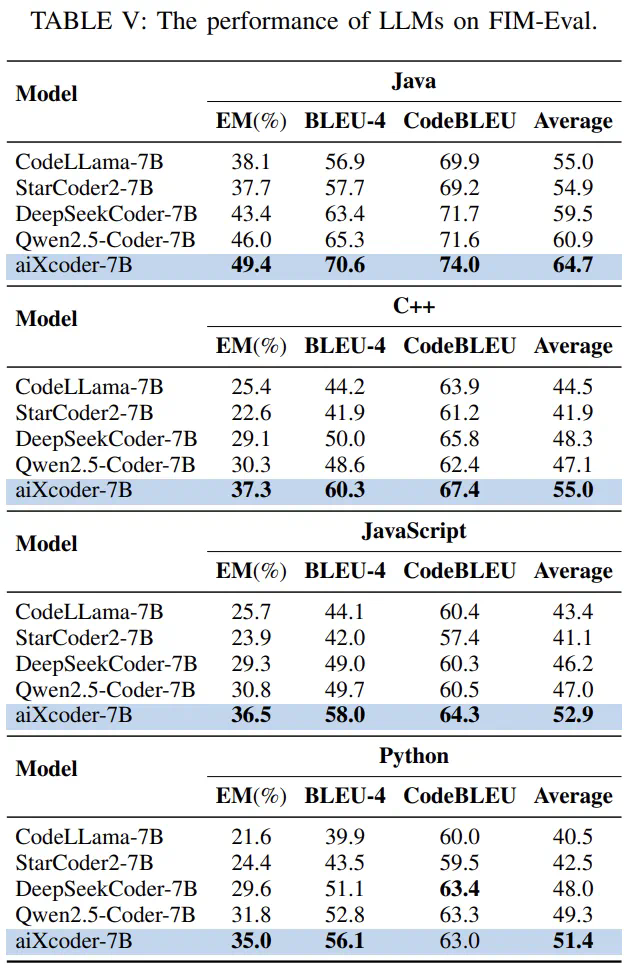

aiXcoder-7B在代码补全任务上展现出显著优势,尤其在处理不同代码结构和跨文件上下文方面。实验结果表明,其在多种语言的代码补全准确率和效率上均优于其他模型。

未来,团队将继续改进模型,以更好地处理复杂的代码上下文,提升代码补全的准确率和效率,最终实现软件开发的自动化。

以上就是如何训练最强代码大模型?北大aiXcoder-7B贡献前沿实践的详细内容,更多请关注其它相关文章!