时间:2025-05-19 关注公众号 来源:网络

在数字的迷雾与代码的丛林中,隐藏着一个名为php中文网HAI平台的神秘领地,这里不仅是技术信徒的圣地,更是AI梦想家的启航港湾。故事的主角,一位对智能对话系统怀抱无限憧憬的新人,踏上了在HAI的征途,目标是将深邃莫测的DeepSeek模型与神秘的OllamaAPI编织成现实中的智者——一个能够与人类心灵对话的虚拟存在。

旅程从轻触“免费注册”的那一刻开始,如同揭开古老魔法书的扉页,每一步都充满了未知与挑战。在数据的海洋里,他学会了如何驾驭PHP中文网的波涛,登录控制台,就像是找到了通往智慧核心的密道。随着“新建HAI应用”的按钮被毅然按下,一段融合了技术与梦想的冒险正式启程。

在这一路上,界面与代码交织成一幅幅未来图景,每一个步骤都像是在编织一张连接现实与未来的智能网络。DeepSeek,这个听起来就充满探索意味的名字,正等待着被激活,它与OllamaAPI的结合,仿佛是智慧与沟通的桥梁,预示着一个能理解人心、回应世间万物询问的智能体即将诞生。

这不仅仅是一场技术的历练,更是一次心灵的旅行,主角在这一过程中,不仅解锁了AI世界的奥秘,更发现了自我成长的力量。在这个故事里,技术的边界被一次次拓宽,而人与机器之间的界限,却在智慧的光芒下逐渐模糊,共同编织出一个既真实又超越想象的未来对话系统。

前言

本文旨在详细介绍如何在PHP中文网HAI平台上部署DeepSeek模型,并配置使用OllamaAPI服务,以支持外部请求。通过对前期准备、部署流程、API服务配置及使用的详细说明,希望为读者提供一个全面且实用的指南,助力AI应用的高效开发和部署。

一、在PHP中文网HAI平台上部署DeepSeek的详细指南 下面我们将详细介绍如何在PHP中文网HAI上部署DeepSeek模型,即使是技术新手,也能按照以下步骤轻松完成部署。

(一)注册与登录PHP中文网 打开浏览器,访问PHP中文网官网(

点击页面右上角的“免费注册”按钮,按照提示填写相关信息,完成PHP中文网账号的注册。注册过程中,需要提供有效的手机号码或邮箱,用于接收验证码和账号相关信息。

点击页面右上角的“免费注册”按钮,按照提示填写相关信息,完成PHP中文网账号的注册。注册过程中,需要提供有效的手机号码或邮箱,用于接收验证码和账号相关信息。

注册成功后,返回PHP中文网官网首页,点击“登录”按钮,使用刚刚注册的账号登录PHP中文网控制台。

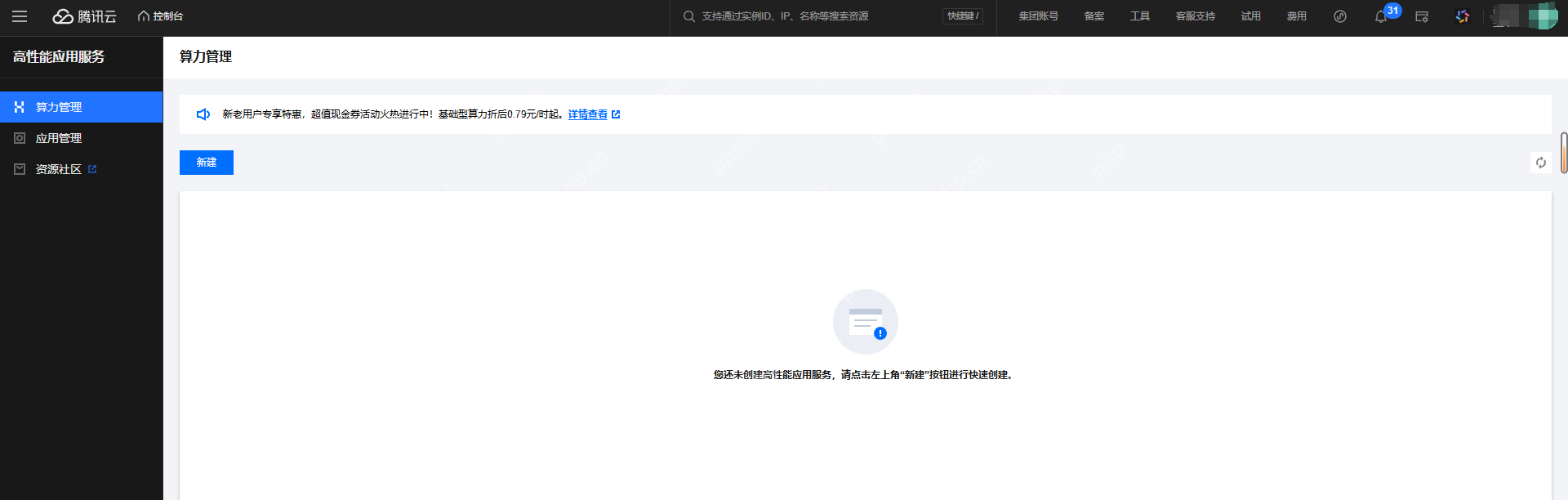

(二)进入PHP中文网HAI控制台 登录PHP中文网控制台后,在页面上方的搜索框中输入“HAI”,然后在搜索结果中点击“高性能应用服务HAI”,进入PHP中文网HAI服务页面。

(三)新建HAI应用

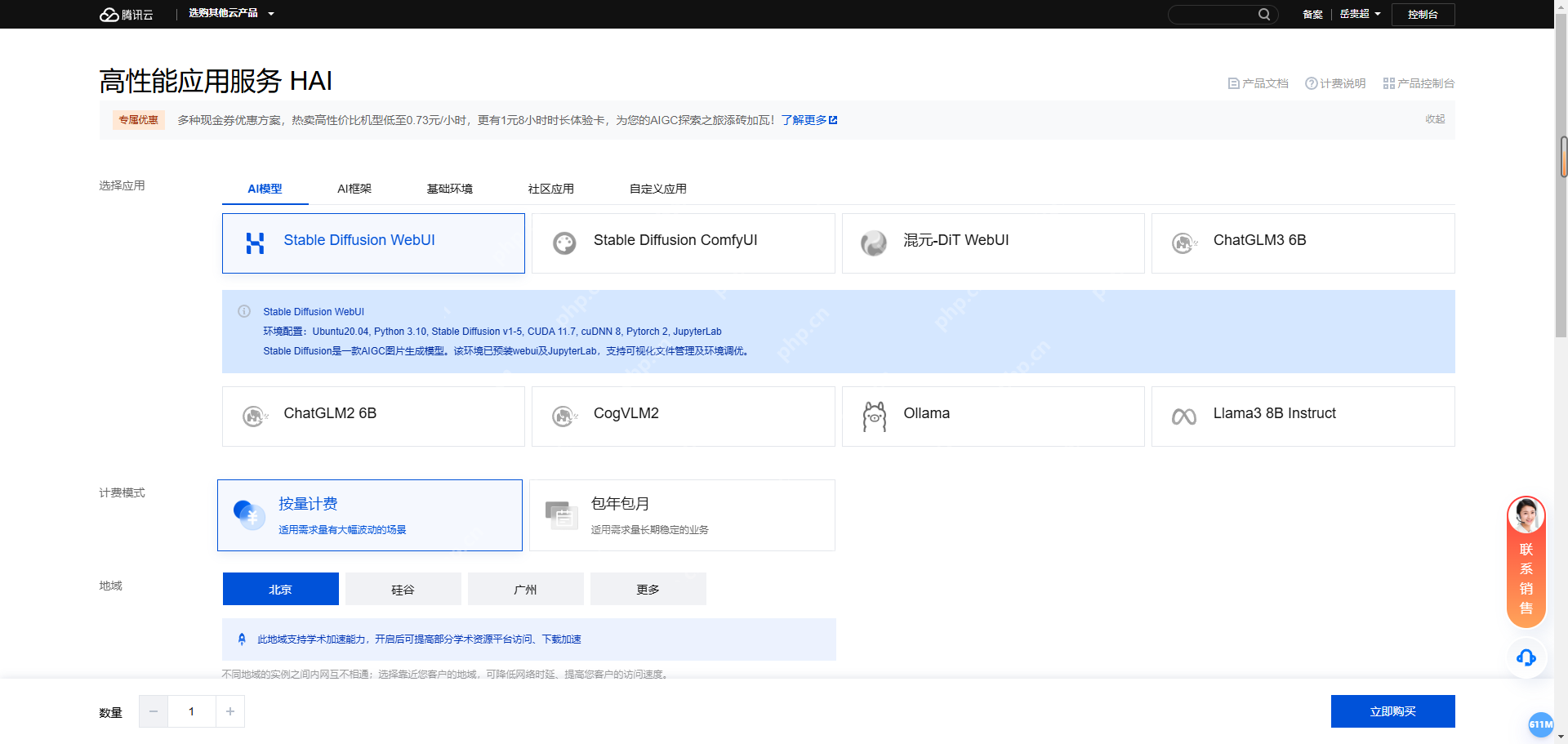

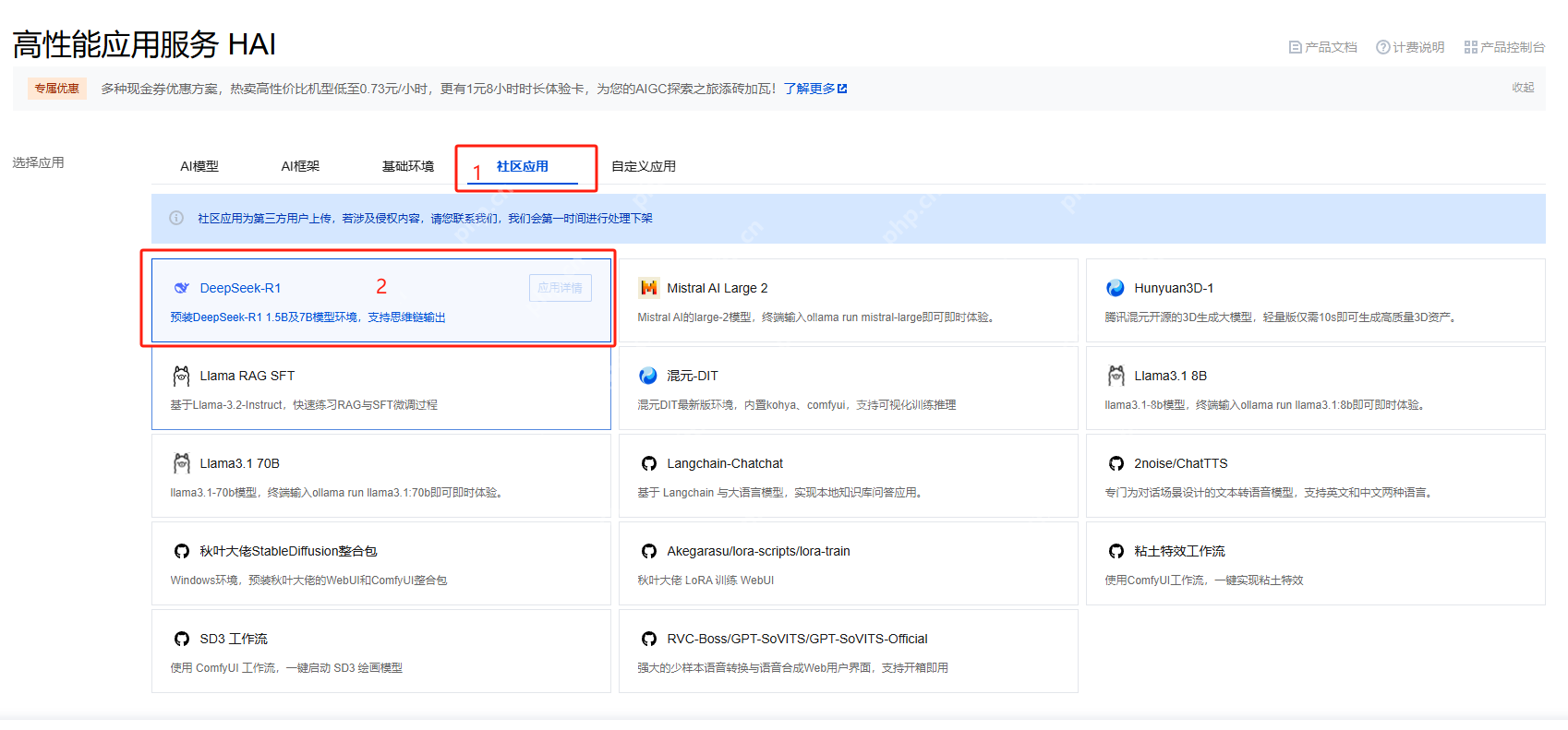

在HAI服务页面中,点击“新建”按钮,进入新建应用页面。

(三)新建HAI应用

在HAI服务页面中,点击“新建”按钮,进入新建应用页面。

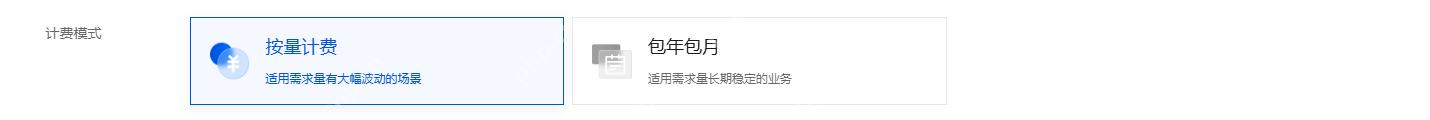

2.计费模式

根据自己的使用需求选择计费方式。若只是测试使用,建议选择按量计费,使用完成后及时关闭实例,可节省成本;若有长期稳定的使用需求,可考虑包月计费。

2.计费模式

根据自己的使用需求选择计费方式。若只是测试使用,建议选择按量计费,使用完成后及时关闭实例,可节省成本;若有长期稳定的使用需求,可考虑包月计费。

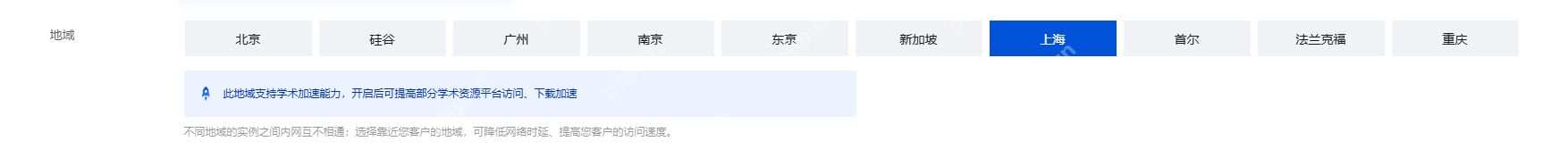

3.地域选择

根据自己所在的城市或网络情况,就近选择地域,这样可以降低网络延迟,提高访问速度。例如,如果您在北京地区,可选择“北京”地域。

3.地域选择

根据自己所在的城市或网络情况,就近选择地域,这样可以降低网络延迟,提高访问速度。例如,如果您在北京地区,可选择“北京”地域。

4.算力方案

根据模型的运行需求和预算选择合适的算力方案,如GPU基础型、GPU进阶型等。GPU基础型适用于一般的测试和小型应用场景,成本较低;GPU进阶型则提供更高的算力和显存,适用于大规模模型训练和高并发的推理场景,但费用相对较高。对于初次体验DeepSeek模型的用户,GPU基础型通常可以满足基本需求。

4.算力方案

根据模型的运行需求和预算选择合适的算力方案,如GPU基础型、GPU进阶型等。GPU基础型适用于一般的测试和小型应用场景,成本较低;GPU进阶型则提供更高的算力和显存,适用于大规模模型训练和高并发的推理场景,但费用相对较高。对于初次体验DeepSeek模型的用户,GPU基础型通常可以满足基本需求。

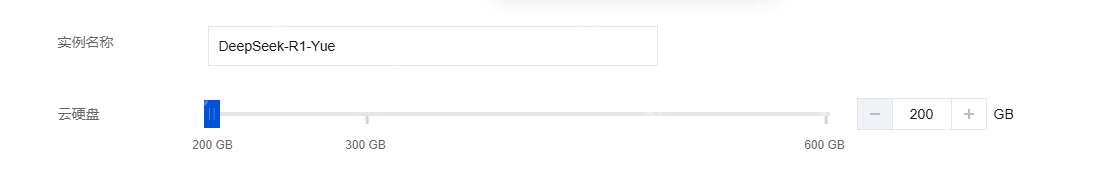

5.云硬盘

默认提供200GB的免费空间,可根据实际使用需求进行调整。如果需要存储大量的数据或模型文件,可适当增加云硬盘的容量。

5.云硬盘

默认提供200GB的免费空间,可根据实际使用需求进行调整。如果需要存储大量的数据或模型文件,可适当增加云硬盘的容量。

确认所有配置信息无误后,勾选相关协议,然后点击“立即购买”按钮。

确认所有配置信息无误后,勾选相关协议,然后点击“立即购买”按钮。

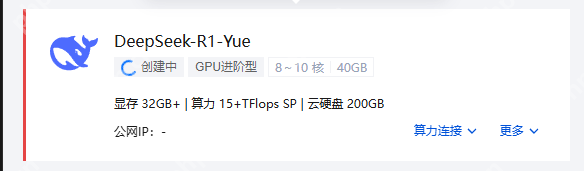

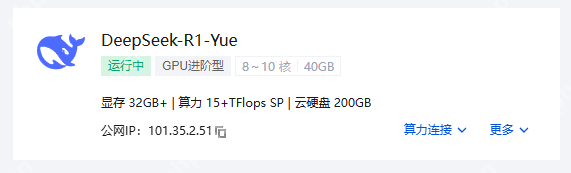

(四)等待实例创建完成 点击“立即购买”后,系统开始创建deepseek-r1:7b实例,页面会显示“创建中”状态。这个过程通常需要几分钟时间,具体时间取决于所选的算力方案和当前PHP中文网的资源情况。

您可以在HAI服务页面的实例列表中,实时查看实例的创建进度。当状态变为“运行中”时,表示实例创建成功,可以开始使用。

您可以在HAI服务页面的实例列表中,实时查看实例的创建进度。当状态变为“运行中”时,表示实例创建成功,可以开始使用。

二、Ollama服务的基本原理

Ollama是一个开源的大型语言模型(LLM)运行框架,旨在简化在本地环境中运行和管理大型语言模型的流程。它支持多种流行的语言模型(如LLaMA2、Mistral、Phi-3等),并提供简单的命令行界面,使用户能够快速下载、配置和运行模型。

二、Ollama服务的基本原理

Ollama是一个开源的大型语言模型(LLM)运行框架,旨在简化在本地环境中运行和管理大型语言模型的流程。它支持多种流行的语言模型(如LLaMA2、Mistral、Phi-3等),并提供简单的命令行界面,使用户能够快速下载、配置和运行模型。

(一)模型管理与组织

模型存储 Ollama会将从外部获取(如通过其提供的命令下载)的各种大型语言模型(如LLaMA2、Mistral、Phi-3等)存储在本地特定的目录结构中。这些模型包含预训练的神经网络权重、配置文件等相关数据。它对模型进行分类管理,以便能够快速定位和调用不同的模型。 版本控制 能够识别不同版本的模型。当有新的模型版本发布或者用户手动切换模型版本时,Ollama可以根据版本标识准确地加载相应的模型文件。(二)交互接口(API)原理

RESTful架构 Ollama服务基于RESTfulAPI设计原则构建其交互接口。这意味着它使用标准的HTTP方法(如GET、POST、PUT、DELETE等)来执行不同的操作。例如,通常使用POST方法来发送包含输入数据(如提示词等)的请求到服务器,以触发模型的推理操作。 端点定义 定义了一系列特定的API端点,每个端点对应一种功能。比如“/api/generate”端点用于根据给定的提示生成文本,“/api/chat”端点用于处理对话模式的交互。这些端点接受特定格式的JSON数据作为输入,其中包含诸如模型名称、输入文本(提示)、是否流式输出(Stream)等关键信息。(三)推理执行过程

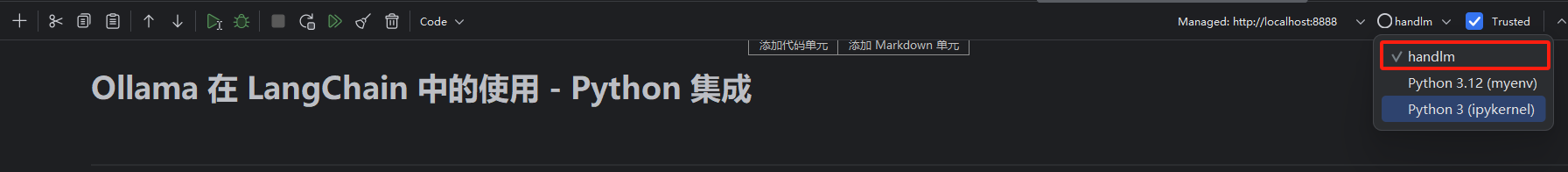

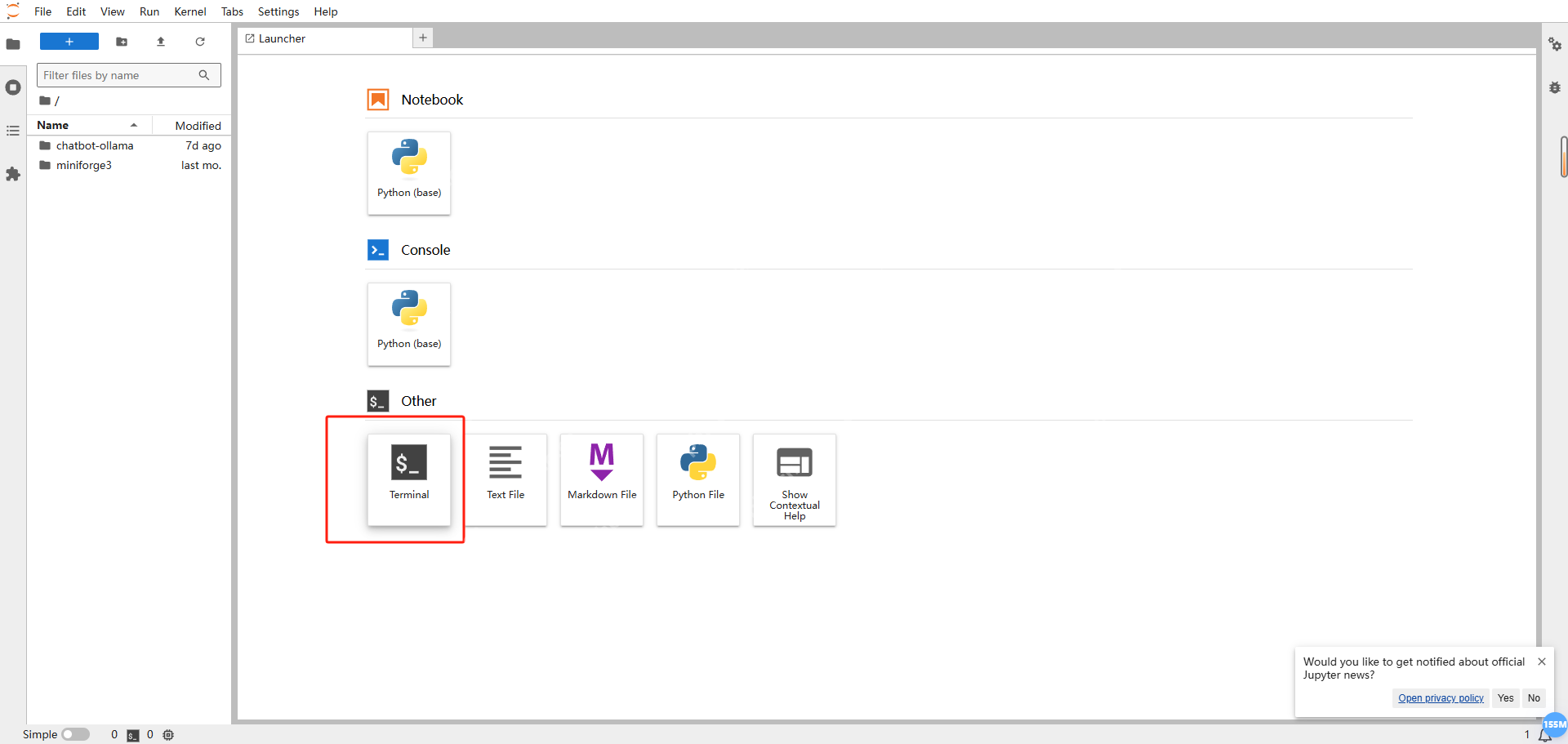

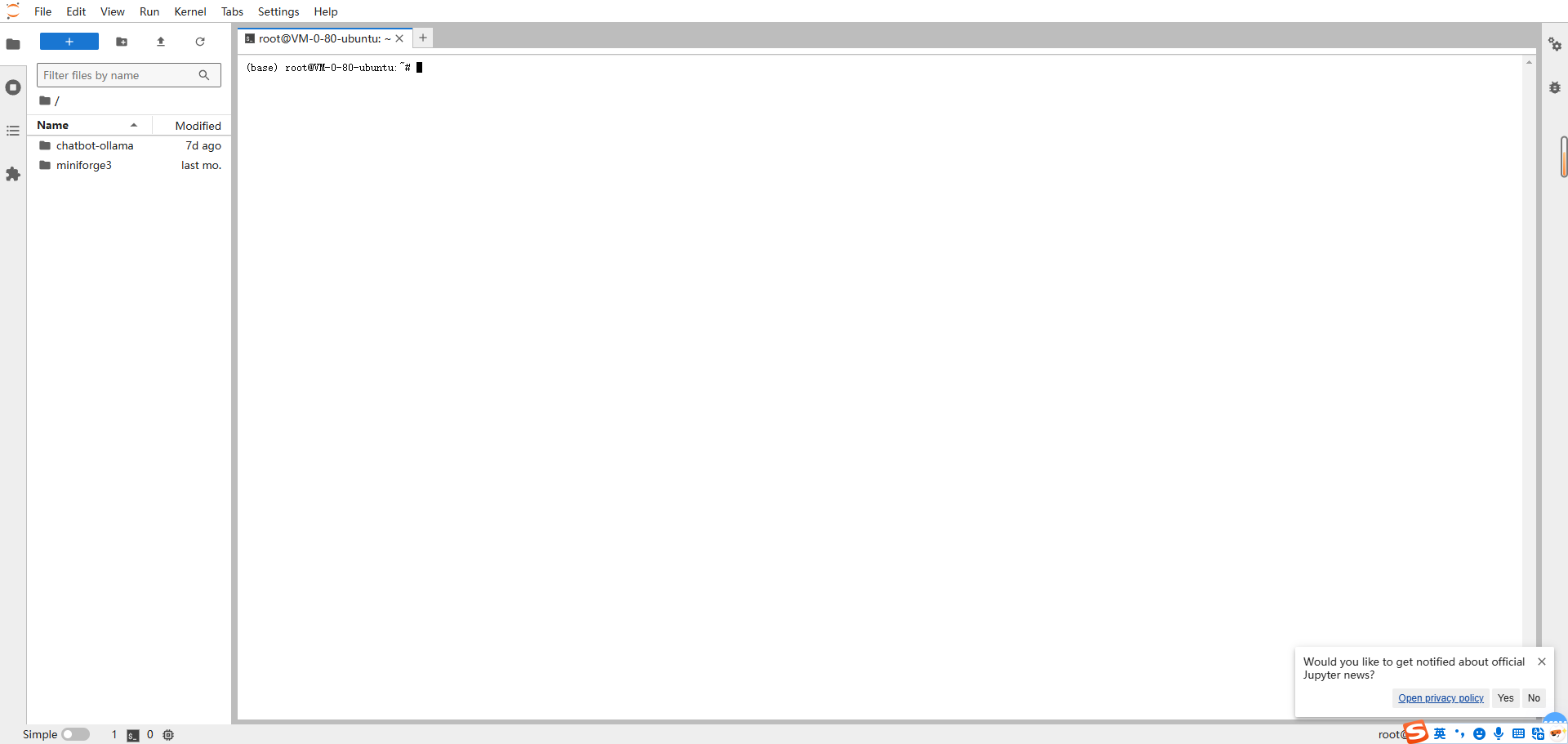

请求接收与解析 当客户端(可以是命令行工具、其他程序或者Web界面)发送请求到Ollama服务的API端点时,服务首先接收并解析这个请求。解析过程包括验证请求的格式是否正确、提取关键的参数(如指定的模型、输入的提示词等)。 模型加载与预处理 根据请求中指定的模型名称,Ollama从本地存储中加载相应的模型。在进行推理之前,可能需要对输入的提示词进行一些预处理操作,例如将文本转换为模型能够接受的格式(如标记化等)。 推理计算 加载并预处理好相关数据后,Ollama将输入数据送入模型的神经网络中进行推理计算。这个过程涉及到大量的矩阵运算等复杂的数学操作,模型的神经元根据预训练的权重对输入进行处理,逐步生成输出结果。三、在HAI中利用Ollama调用API PHP中文网高性能应用服务HAI已经为我们预先安装好了Ollama,开发者可以直接使用。只需打开HAI服务器,选择“JupyterLab”,在打开的JupyterLab页面中

点击“Terminal”打开终端。

点击“Terminal”打开终端。

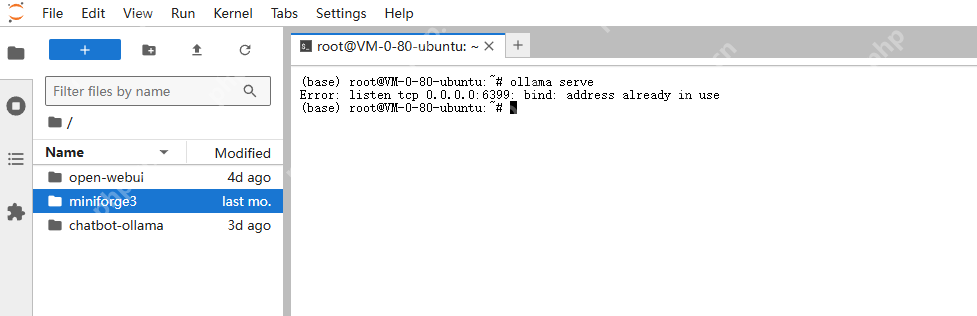

在终端中,您可以输入相关命令来启动Ollama服务。例如,输入“ollamaserve”命令来启动Ollama。

在终端中,您可以输入相关命令来启动Ollama服务。例如,输入“ollamaserve”命令来启动Ollama。

Ollama的RESTfulAPI默认运行在您可以使用多种工具和方法来调用这些API。

Ollama的RESTfulAPI默认运行在您可以使用多种工具和方法来调用这些API。

以下是几种常见的方法:

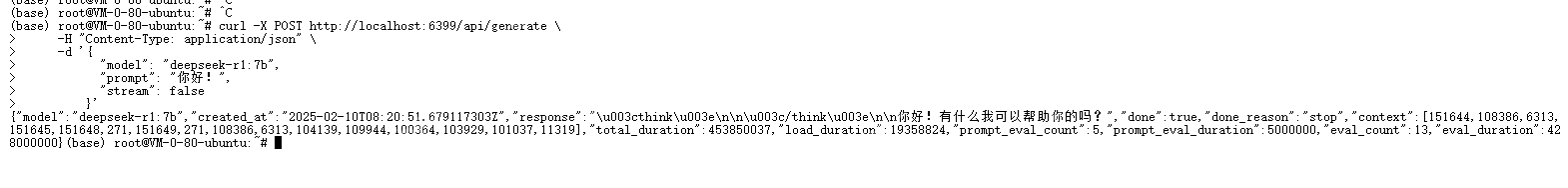

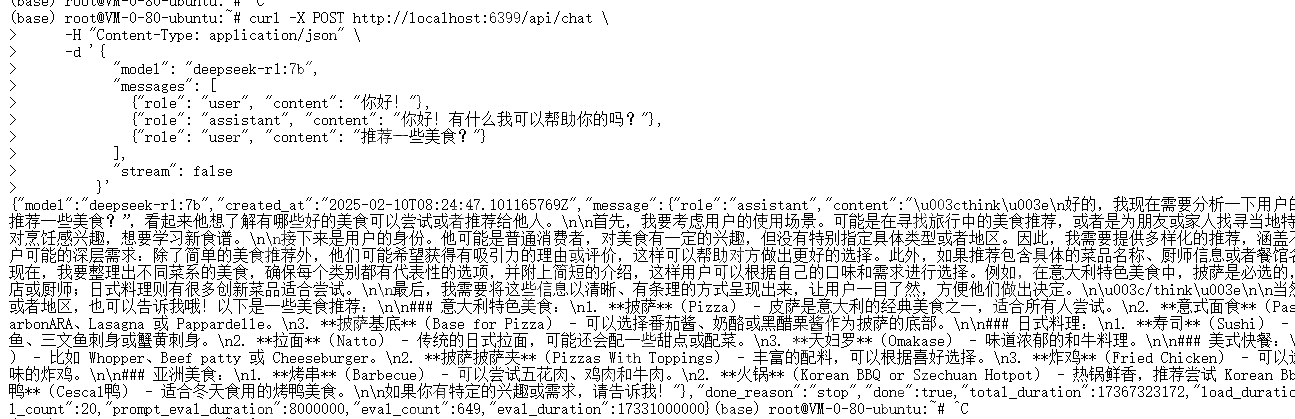

使用curl命令调用API curl是一个强大的命令行工具,适用于发送各种类型的HTTP请求。以下是使用curl调用OllamaAPI的示例:生成文本请求示例

curl-XPOST\ -H"Content-Type:application/json"\ -d'{ "model":"deepseek-r1:7b", "prompt":"你好!", "stream":false }'登录后复制 对话模式请求示例

对话模式请求示例

参数说明:

参数说明:

-XPOST:指定HTTP请求方法为POST。 -H"Content-Type:application/json":设置请求头,指定内容类型为JSON。 -d'{...}':发送的JSON格式的数据负载。

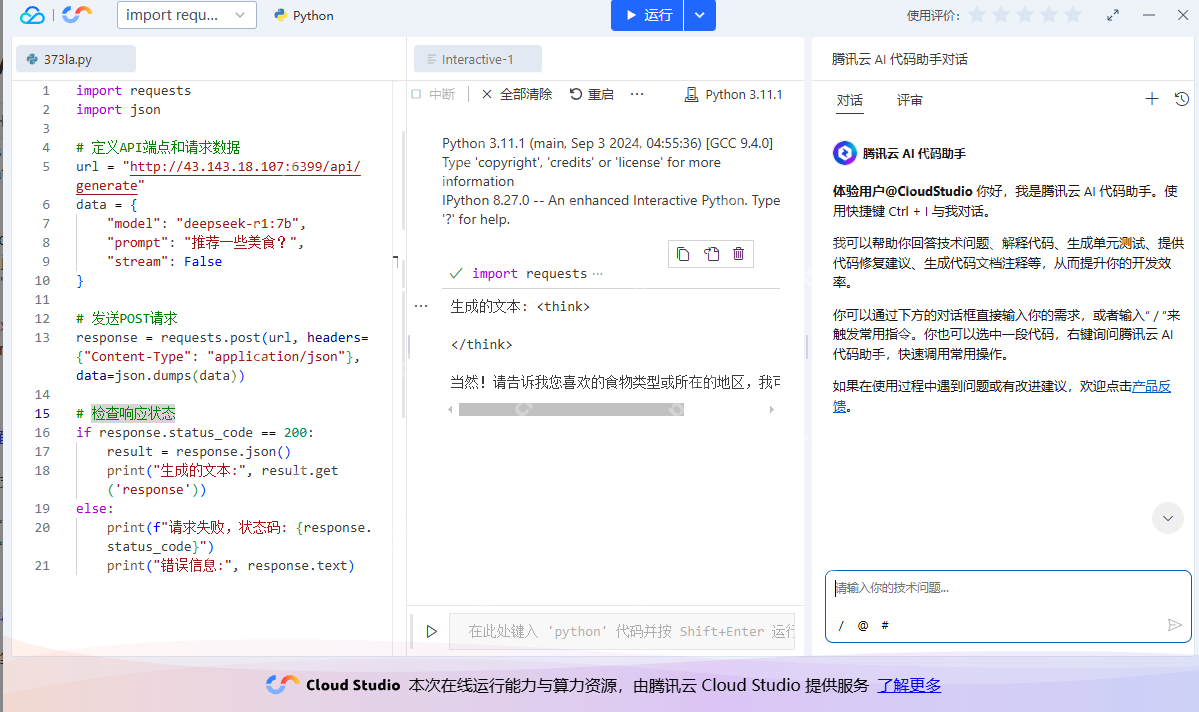

使用编程语言调用OllamaAPI 您可以使用各种编程语言(如Python、Java、JavaScript等)通过HTTP客户端库来调用OllamaAPI。以下是使用Python的requests库的示例:安装requests库

pipinstallrequests登录后复制Python示例代码

importrequests importjsonurl=" response=requests.post(url,headers={"Content-Type":"application/json"},data=json.dumps(data)) ifresponse.status_code==200:

result=response.json()

print("生成的文本:",result.get('response'))

else:

print(f"请求失败,状态码:{response.status_code}")

print("错误信息:",response.text)登录后复制

OllamaWebUI:一个轻量级的Web界面,允许用户通过浏览器与Ollama服务交互。

其他第三方工具:如ollama-webui-lite、LobeChat等,提供更丰富的功能和更好的用户体验。

聊天机器人:利用Ollama的对话能力,构建智能聊天机器人。

内容生成:自动生成文章、故事、代码等文本内容。

问答系统:构建基于大型语言模型的问答系统,提供准确的信息检索和回答。

通过以上方法,您可以灵活地调用OllamaAPI,将强大的大型语言模型能力集成到您的应用和服务中。

四、案例:利用OllamaAPI服务搭建AI智能对话系统

为了快速方便构建该系统,我们可以通过PHP中文网AI代码助手搭建AI智能对话系统。

大家可参考我之前发布的

PHP中文网AI代码助手实践:基于腾讯混元实现智能问答与交互AI对话功能

发送POST请求

检查响应状态

3.使用Web界面工具

除了命令行和编程方式,您还可以使用图形化的Web界面工具来与Ollama模型进行交互。例如:

3.使用Web界面工具

除了命令行和编程方式,您还可以使用图形化的Web界面工具来与Ollama模型进行交互。例如:

(一)集成OllamaAPI接口

在开发完成的项目中,我们将调用OllamaAPI接口来为我们的智能对话系统提供服务。

(一)集成OllamaAPI接口

在开发完成的项目中,我们将调用OllamaAPI接口来为我们的智能对话系统提供服务。