时间:2025-05-16 关注公众号 来源:网络

在智力与策略的璀璨交锋中,《时空谜题》大赛燃起了智慧的火花。这场备受瞩目的竞赛,汇聚了来自四面八方的解谜高手,其中,GRPO以其非凡的洞察力和创新思维,成为了万众瞩目的焦点。面对强劲对手o1的精准逻辑,o3-mini的敏捷解题速度,以及R1的深厚策略底蕴,GRPO不仅展现了深厚的解谜功底,更以独到的解题策略和临场应变能力,逐一攻克难题,最终在紧张激烈的对决中脱颖而出。这场比赛不仅是技巧的较量,更是智慧灵感的碰撞,GRPO的胜利,为《时空谜题》的历史添上了浓墨重彩的一笔,证明了在变幻莫测的谜题世界里,创新与坚持是通往胜利的不二法门。

openpipe平台最新研究:开源模型通过强化学习在复杂推理任务中超越顶级闭源模型

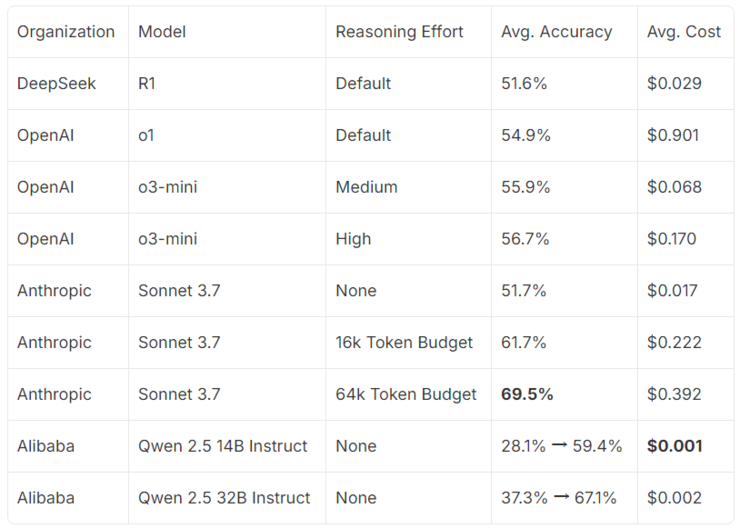

OpenPipe平台近期发布的一项研究显示,通过运用GRPO强化学习算法,其团队成功地使开源模型Qwen在重度推理游戏《时空谜题》中的表现超越了DeepSeekR1、OpenAI的o1和o3-mini等业界领先模型。该研究由EnderReSearch的强化学习研究员BradHilton和OpenPipe创始人KyleCorbitt共同完成。

研究结果表明,该方法不仅将模型与ClaudeSonnet3.7的性能差距缩小到个位数百分比,同时实现了超过100倍的推理成本优化。研究报告详细介绍了任务设计、超参数调整经验以及基于Torchtune框架构建的完整训练方案。

研究背景:大型语言模型的推理能力瓶颈

自OpenAI发布o系列推理模型以来,基于强化学习训练的LLM发展迅速。然而,逻辑演绎能力仍然是这些模型的短板,主要体现在以下三个方面:

难以稳定追踪所有相关细节; 无法保持逻辑严密的推演过程; 多步推理衔接可靠性不足。即使是顶尖模型,也经常会出现人类容易识别的低级错误。

《时空谜题》基准测试:挑战现有模型的推理极限

为了评估模型的推理能力,研究团队使用了自定义的推理任务——《时空谜题》。该谜题类似于经典桌游Cluedo,但增加了时间和动机维度,并使用OR-Tools的CP-SAT求解器生成谜题。

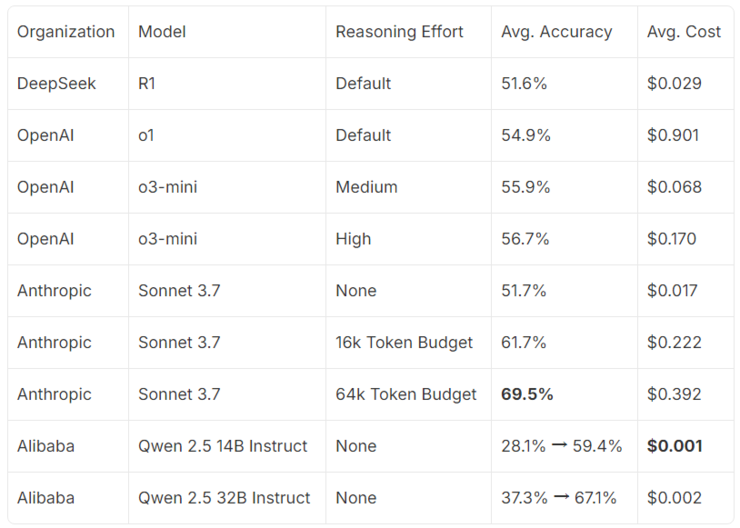

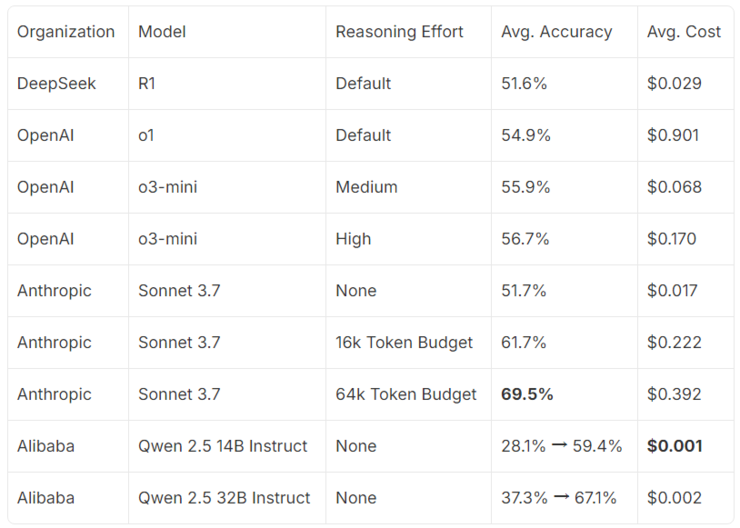

研究人员对DeepSeekR1、OpenAI的o1和o3-mini、Anthropic的ClaudeSonnet3.7以及Qwen14B和32B模型进行了基准测试。结果显示,ClaudeSonnet3.7表现最佳,而未经调优的Qwen模型性能相对较弱。

GRPO算法与高效训练方案:突破性能瓶颈的关键

研究团队采用GRPO强化学习算法对Qwen模型进行训练。与PPO等传统方法相比,GRPO算法在简化训练过程的同时,也取得了显著的性能提升。

训练过程主要包括以下步骤:

模型生成多个答案; 对答案进行评分,计算优势值; 利用优势值引导策略梯度更新模型参数; 重复上述步骤,直至达到最佳性能。研究中还使用了vLLM推理引擎、HuggingFaceTransformersAutoTokenizer以及Torchtune库,并对参数进行了精细的调优,以提高训练效率和模型性能。Torchtune库提供的功能包括激活检查点、激活卸载、量化和PEFT等。

研究结果:显著提升性能并降低成本

经过100多次迭代训练,Qwen模型的推理性能得到了显著提升,140亿参数的模型接近ClaudeSonnet3.7的水平,而320亿参数的模型则几乎达到了Sonnet的性能。

更重要的是,该方法大幅降低了推理成本,实现了超过100倍的优化。研究还发现,仅需16个训练样本就能实现高达10-15%的性能提升。

结论:强化学习在提升开源模型推理能力方面的巨大潜力

这项研究证明了强化学习在提升开源模型推理能力方面的巨大潜力。通过GRPO算法和高效的训练方案,即使是相对较小的开源模型也能在复杂的推理任务中达到甚至超越顶级闭源模型的性能,同时大幅降低成本。这为开源社区提供了新的方向,也为未来LLM的发展提供了新的思路。

以上就是GRPO在《时空谜题》中击败o1、o3-mini和R1的详细内容,更多请关注其它相关文章!

" alt="行业首批!腾讯云TI平台支持DeepSeek全系模型精调与推理">

" alt="行业首批!腾讯云TI平台支持DeepSeek全系模型精调与推理">