时间:2025-05-16 关注公众号 来源:网络

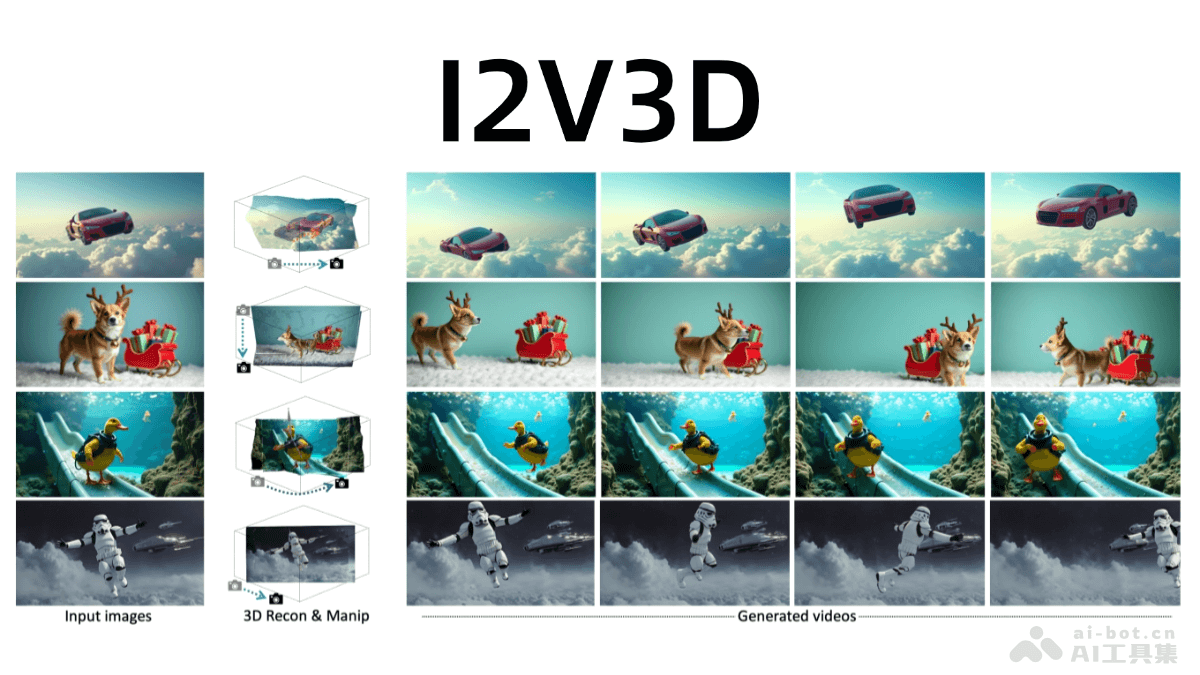

在数字媒体技术的浩瀚蓝海中,香港城市大学携手全球科技巨擘微软,共同揭开了I2V3D技术框架的神秘面纱。这一创新成果标志着图像到视频生成领域的一次重大飞跃。I2V3D,作为一项前沿技术,它不仅能够将静态图像魔术般地转换为生动的三维视频,还赋予了内容创作者前所未有的表达力,使得创意无限延伸。通过高度先进的算法和深度学习技术,I2V3D框架能够细腻捕捉图像的每一细节,进而编织出流畅、逼真的动态视觉效果,为影视制作、虚拟现实、广告设计等行业带来了全新的创作可能。这项技术的诞生,不仅是科技与艺术的完美融合,也是对未来视觉传播方式的一次大胆探索和革新。

i2v3d:将静态图像变为动态视频的革新框架

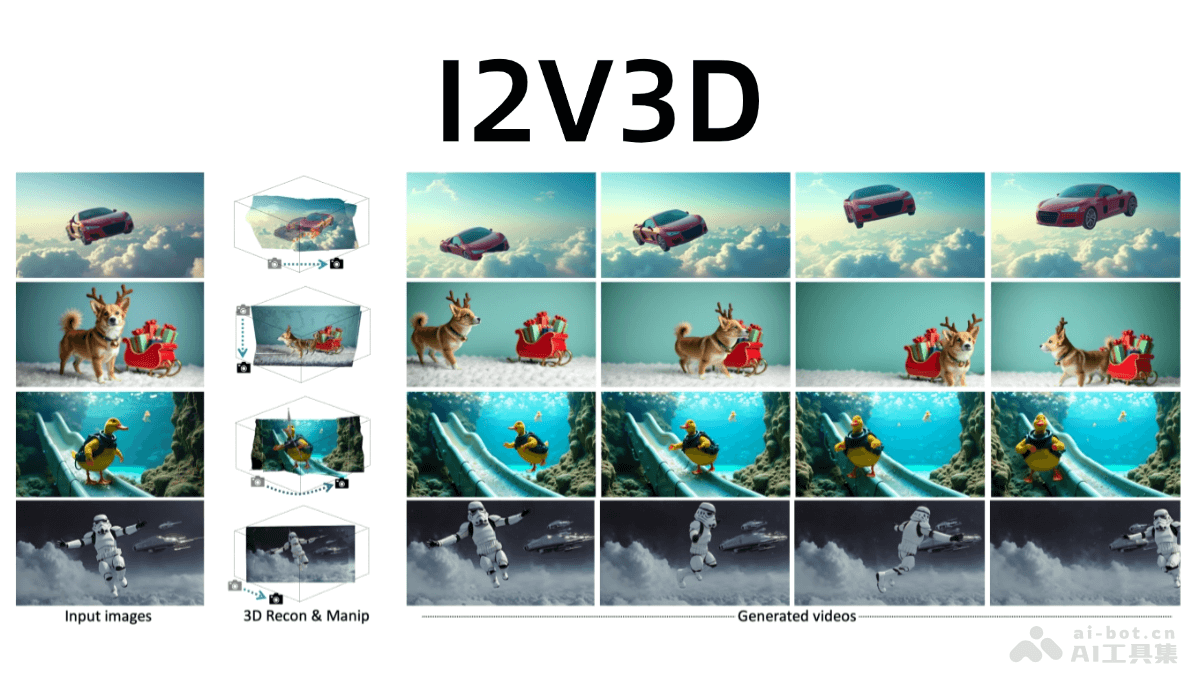

I2V3D是由香港城市大学和微软GenAI联合研发的图像到视频生成框架,它能够将静态图像转化为栩栩如生的动态视频,并基于3D几何引导技术实现精准的动画控制。该框架巧妙地结合了传统计算机图形学(CG)的精确控制能力和生成式AI模型的高视觉保真度,采用两阶段生成流程:首先是3D引导的关键帧生成,然后是视频插值,从而生成高质量、可控的视频。I2V3D支持复杂的3D动画和相机运动,用户可以从任意初始点开始动画,生成任意长度的视频序列,极大地降低了创作门槛,简化了视频生成流程。这为动画制作、视频编辑和内容创作等领域提供了高效灵活的解决方案。

I2V3D核心功能:

I2V3D核心功能:

I2V3D技术原理详解:

3D几何重建:从单张图像重建完整的3D场景几何结构,包括前景对象和背景。前景对象被提取并转化为3D网格,背景则通过多视图生成和3D网格重建完成。 两阶段视频生成流程: 3D引导的关键帧生成:使用定制化的图像扩散模型,以粗糙渲染结果为引导,生成高质量的关键帧。多视图增强和扩展注意力机制提升了模型的泛化能力和时间一致性。 3D引导的视频插值:在关键帧之间生成平滑、高质量的视频帧。该过程无需额外训练,基于双向引导(正向和反向)确保视频的时间连贯性。 深度引导与特征控制:利用深度图和渲染特征(如自注意力特征和卷积特征)作为控制信号,确保生成的视频与3D渲染结果保持一致。 扩展注意力机制:采用扩展注意力机制,在关键帧生成阶段增强帧与帧之间的时空一致性,避免视频出现闪烁或不连贯等问题。I2V3D项目信息:

项目官网: arXiv技术论文:I2V3D应用领域:

动画制作:快速生成动态视频,支持复杂3D动画,适用于广告、游戏等短动画制作。 视频编辑与创作:在3D场景中添加、替换或修改对象,创作新颖的视频内容,适用于短视频和特效预览。 VR/AR内容生成:生成逼真的3D动态内容,用于虚拟环境的交互演示,提升沉浸感。 教育与培训:将静态教学插图转换为动态视频,帮助学生更直观地理解复杂概念。 游戏开发:快速生成游戏过场动画或虚拟角色动画,提高开发效率,降低成本。以上就是I2V3D—香港城市大学联合微软推出的图像到视频生成框架的详细内容,更多请关注其它相关文章!