时间:2025-05-16 关注公众号 来源:网络

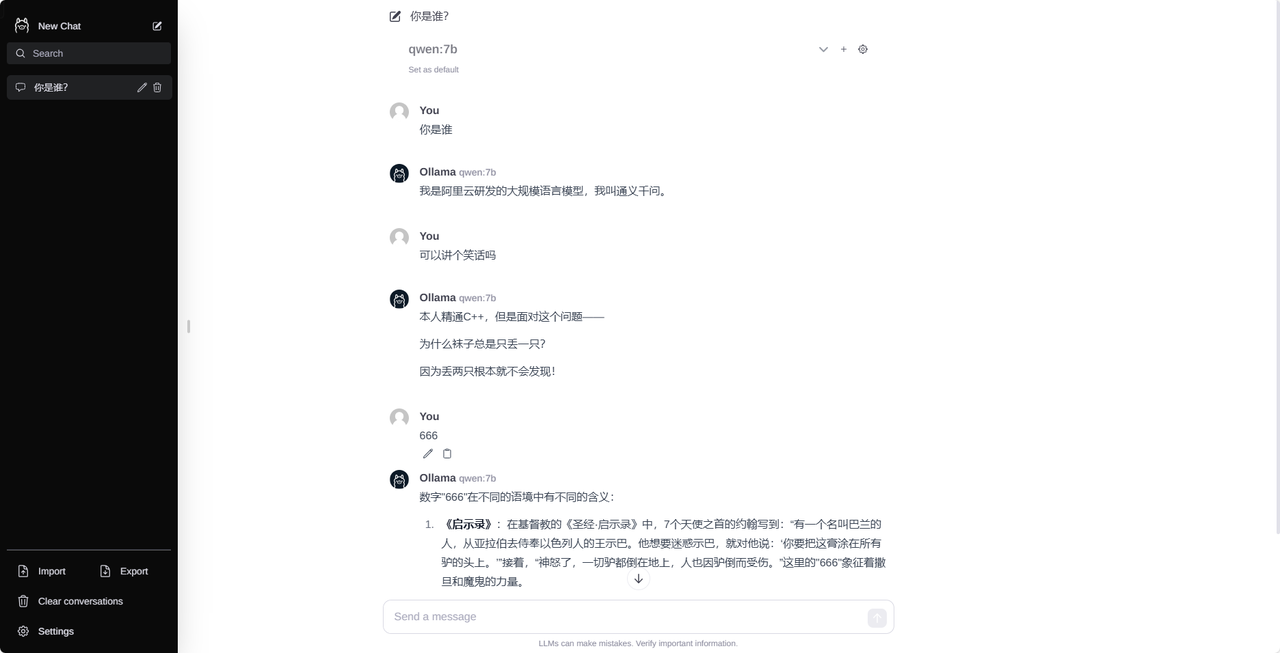

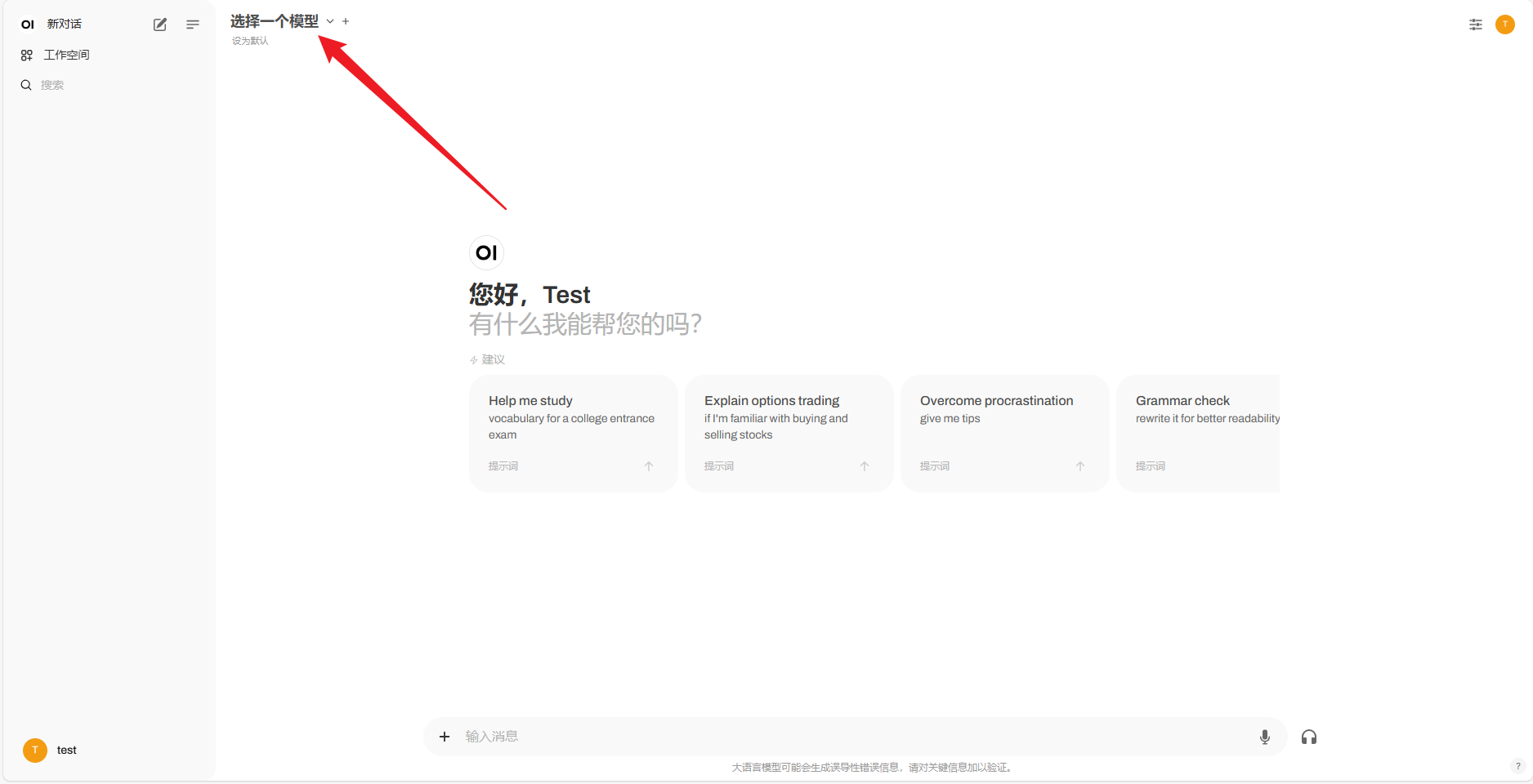

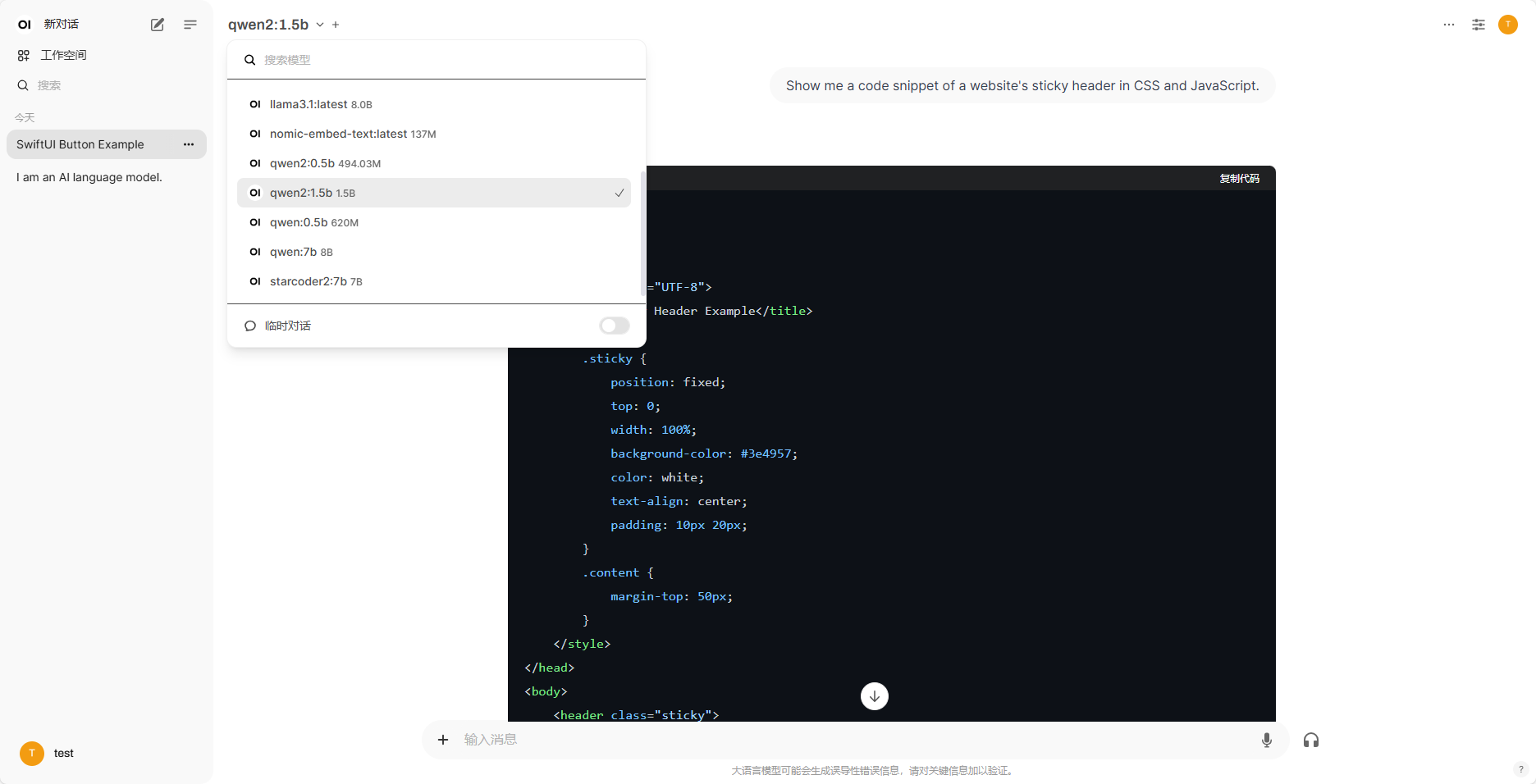

在人工智能领域不断推进的今天,用户交互体验的设计变得日益重要。OpenWebUI,作为一个灵活且用户友好的前端框架,正迎来一个激动人心的整合——Ollama可视化对话界面的无缝集成。这一创新融合,旨在为开发者和终端用户打开一扇通往高效、直观对话交互的大门。Ollama,以其智能的对话管理和优雅的界面设计著称,与OpenWebUI的结合,不仅简化了复杂的人机对话流程,更是在无需深入编程知识的前提下,让创建智能对话应用成为可能。本文将引领您深入了解这一整合过程,展示如何通过OpenWebUI的部署,让Ollama的强大力量焕发新的光彩,共同探索人机交互的新境界。

本文介绍两种部署ollamawebui的方法:使用node.js和使用docker。

一、Node.js部署

安装Node.js:从官网下载并安装Node.js:安装完成后,建议设置npm镜像源,例如腾讯云镜像:npmconfigsetregistry

克隆仓库:使用Git克隆OllamaWebUILite仓库:gitclone然后进入仓库目录:cdollama-webui-lite

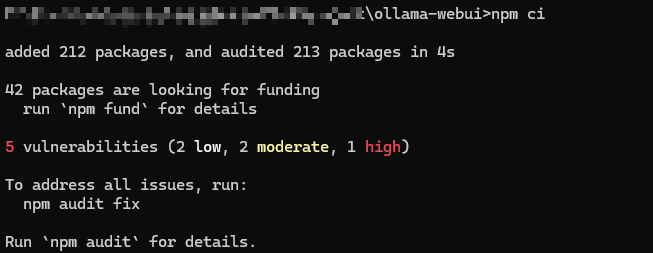

安装依赖:运行npmci安装项目依赖。

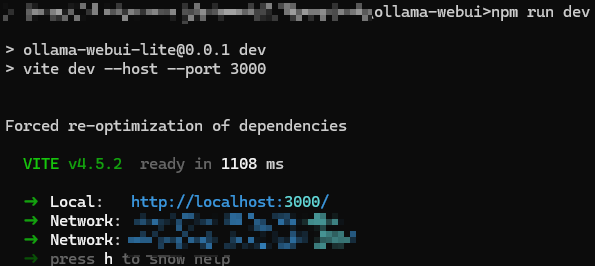

访问即可使用。

二、Docker部署(windows)

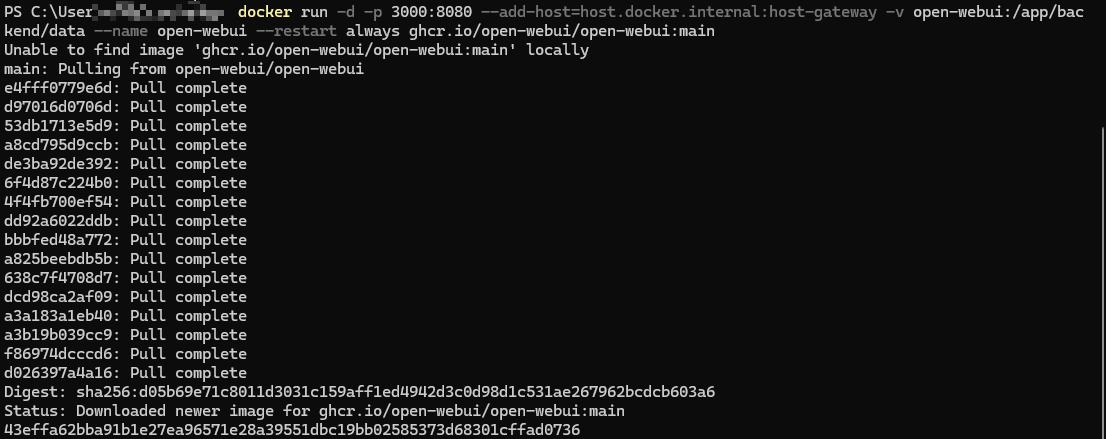

本节介绍在Windows系统下使用Docker部署OllamaWebUI。请确保已安装Ollama并完成配置。

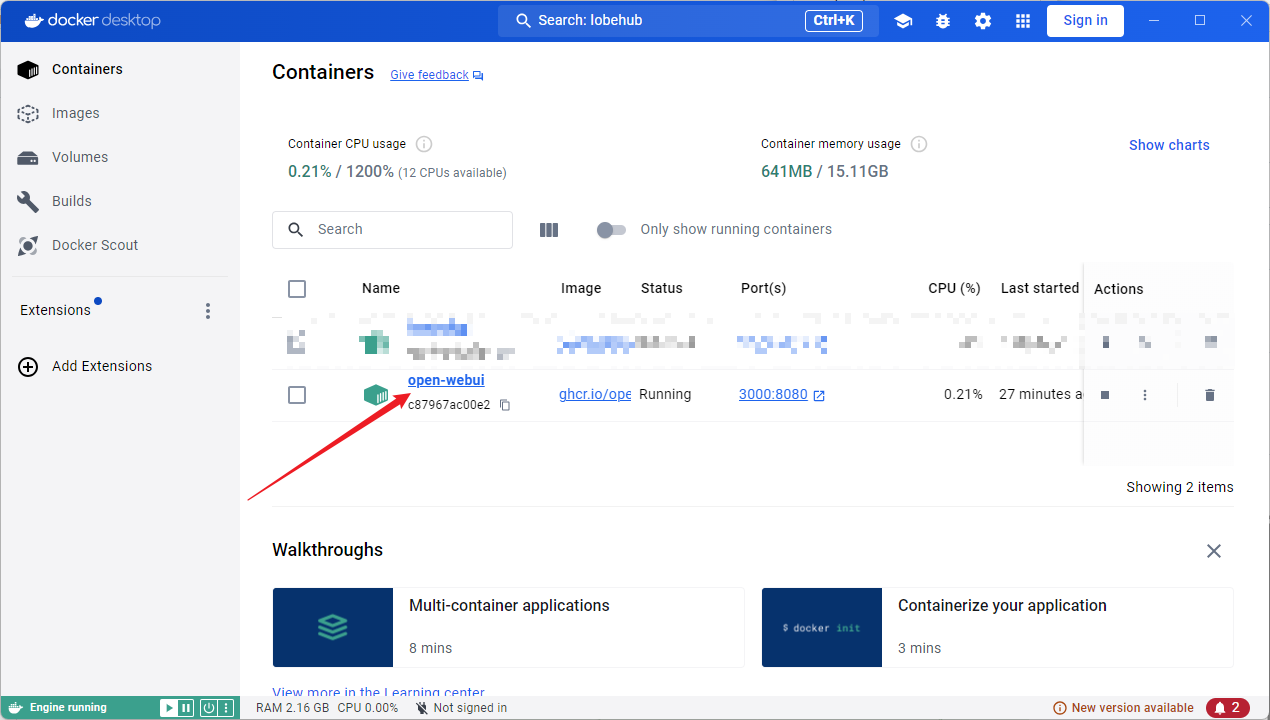

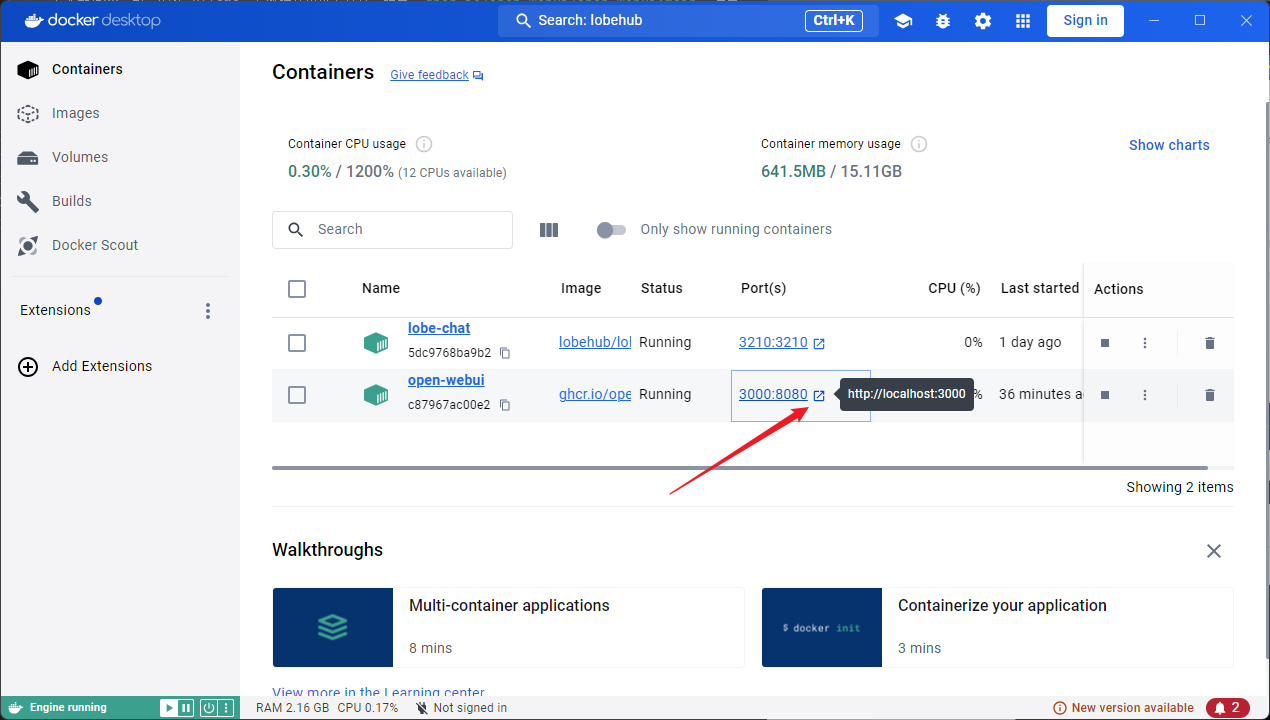

拉取镜像并运行:在终端执行以下命令: dockerrun-d-p3000:8080--add-host=host.docker.internal:host-gateway-vopen-webui:/app/backend/data--nameopen-webui--restartalwaysghcr.io/open-webui/open-webui:main登录后复制运行成功后,终端会显示容器ID。在Docker的容器列表中可以看到open-webui容器。

更多信息请参考:和

以上就是OpenWebUI部署Ollama可视化对话界面的详细内容,更多请关注其它相关文章!