时间:2025-05-16 关注公众号 来源:网络

在技术开源的浪潮中,DeepSeek再次迈出坚实的一步,正式开源了其精心研发的MoE(Mixture of Experts)训练与推理通信库——DeepEP。这一举措不仅展现了DeepSeek对促进AI技术普惠的承诺,更是为业界提供了一款强大、高效的通信工具,旨在优化大规模专家模型的协同工作。DeepEP的问世,对于追求高性能计算和资源优化的研究人员及开发者而言,无疑是一大福音。它通过优化通信协议,有效解决了多专家模型在分布式环境下的训练与推理效率难题,降低了大型语言模型和复杂AI系统的部署门槛。这一创新之举,将进一步加速AI技术的开放合作与实际应用进程,引领我们步入更加开放、高效的技术共享时代。

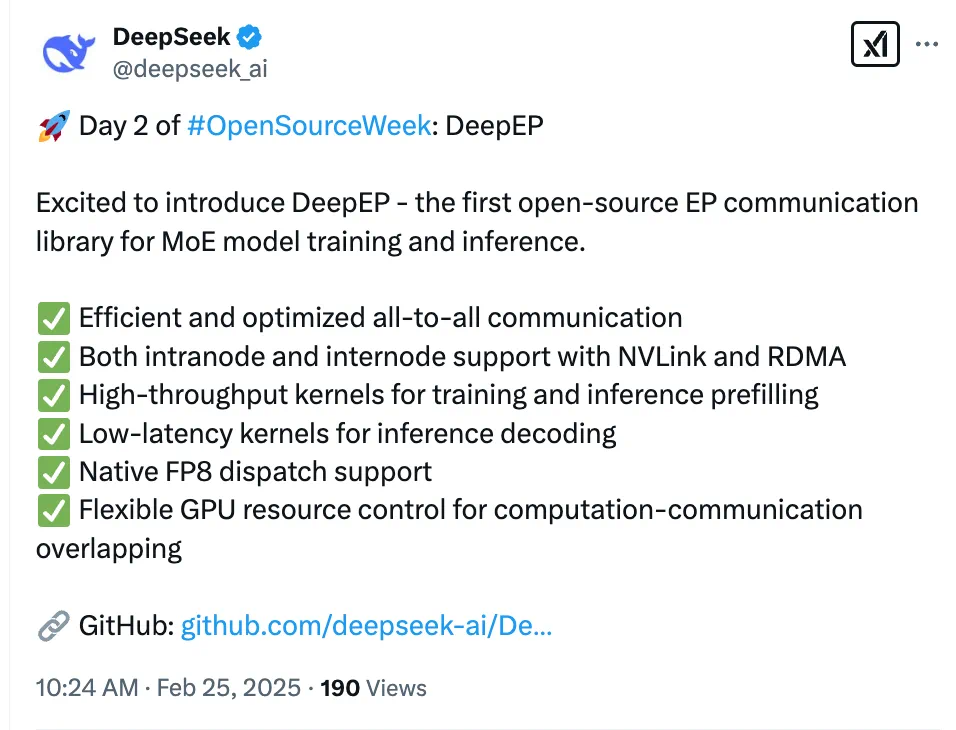

deepseek开源盛宴:高效moe通信库deepep震撼登场!继高效mla解码核开源后,deepseek在开源周的第二天重磅推出deepep——首个用于moe模型训练和推理的ep通信库,短短时间内star数已突破千!

DeepEP针对分布式系统中MoE模型的通信瓶颈,进行了多项关键优化:

高效All-to-All通信:显著提升数据传输效率。 支持NVLink和RDMA:实现节点内/跨节点的高速通信。 高吞吐量训练/推理预填充核心:优化预填充阶段的计算速度。 低延迟推理解码核心:降低延迟敏感的推理解码阶段的耗时。 原生支持FP8数据分发:提升计算效率。 灵活的GPU资源控制:实现计算与通信的高效重叠,避免等待。 项目链接:

项目链接:

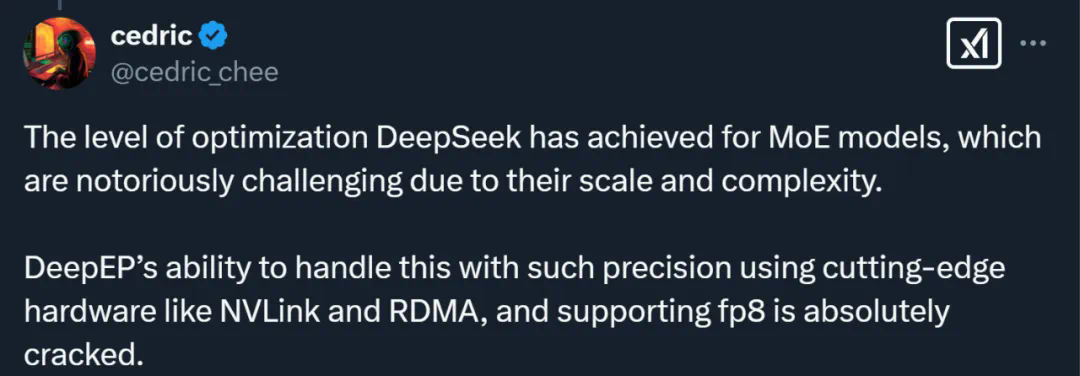

DeepEP的优异性能已获得广泛认可,众多开发者称其为MoE模型领域的突破性进展,尤其是在NVLink和RDMA支持方面,更是被誉为革命性的突破。

DeepEP的开源,进一步印证了DeepSeek在AI基础设施领域的创新实力,也为MoE模型的训练和推理效率提升提供了强有力的支撑。此前关于DeepSeek-R1的质疑,也因DeepEP等项目的开源而得到部分解答。

DeepEP核心功能详解:

DeepEP是一个为MoE和EP量身打造的通信库,提供高吞吐量和低延迟的all-to-allGPU内核(MoE分发和合并)。支持FP8低精度操作,并针对DeepSeek-V3论文中提出的group-limitedgating算法,优化了跨不同带宽域(如NVLink到RDMA)的数据转发,兼顾训练和推理的高效性。此外,还包含一套纯RDMA低延迟内核,用于对延迟敏感的推理解码任务。通过hook-based的通信-计算重叠方法,最大限度地提升效率。

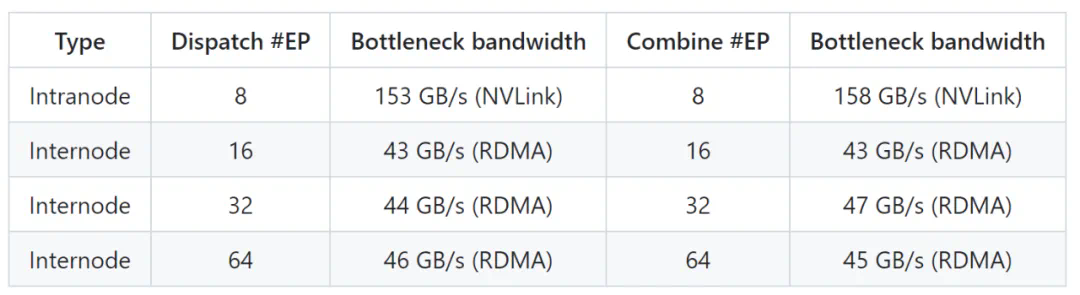

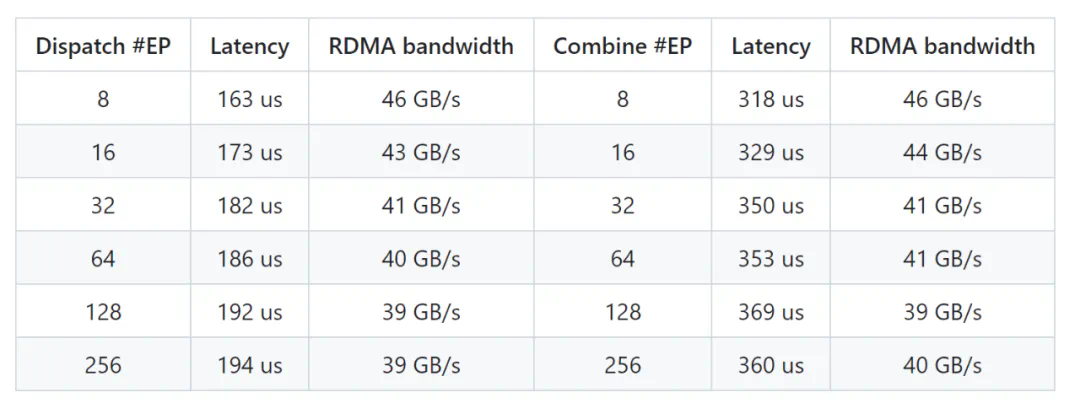

性能测试结果:文中包含了DeepEP在H800平台上,使用常规内核和低延迟内核的性能测试数据图表(包含NVLink和RDMA转发)。

注意事项:DeepEP使用了未公开的PTX指令,可能在某些平台上存在兼容性问题,开发者可根据文档中的说明进行调整。

DeepSeek开源行动仍在继续,让我们拭目以待明天将会有哪些惊喜!

以上就是刚刚,DeepSeek开源MoE训练、推理EP通信库DeepEP,真太Open了!的详细内容,更多请关注其它相关文章!