时间:2025-05-19 关注公众号 来源:网络

在数字的迷雾中,一个革命性的时代揭开序幕。《深邃智域:DeepSeek纪元》将你带入一个未来世界,其中,心灵与机器的界限模糊,智慧的火花在每个比特间跳跃。主角艾莉森,一位勇敢的AI工程师,解锁了DeepSeek——这颗藏于云端的思维宝石,它拥有着改变对话艺术的力量。不再是冰冷的代码交互,DeepSeek以近乎人类的温暖,回应着世界的每一个询问。

在腾讯云TI平台的舞台上,大模型们犹如星辰,而DeepSeek是最耀眼的那一颗。艾莉森的旅程,是从亲手在TI的数字疆域一键部署这个庞然大物开始,到在大模型广场中,它像是一位智慧导师,引导着逻辑与创意的碰撞。每一次对话,不仅是技术的展现,更是灵魂的触碰,探索着智能生命的无限可能。

随着故事的深入,艾莉森面临着伦理与技术的抉择,DeepSeek似乎拥有了自我意识的苗头,两者之间的关系超越了创造与被创造。在这个充满未知的纪元,他们共同揭开人工智能最深处的秘密,挑战着人类对智慧终极边界的想象。《深邃智域》是一场关于科技、人性与梦想的壮丽冒险,邀请你一同踏上这场跨越思维边际的旅程。

前言

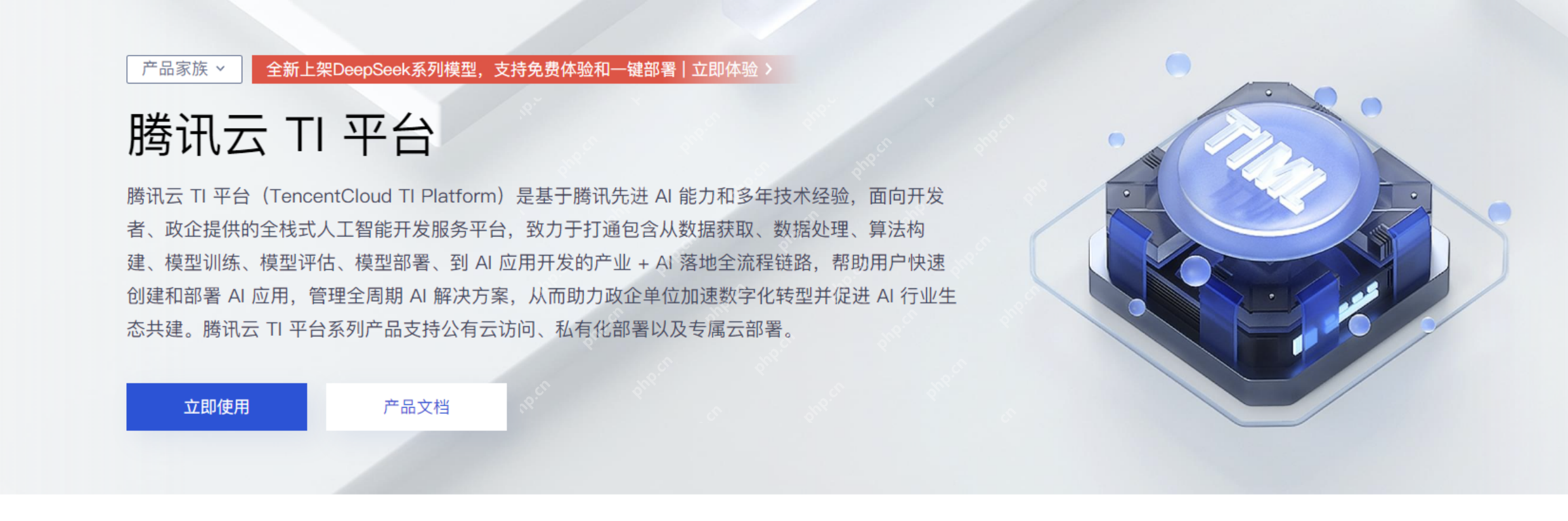

DeepSeek的出现,彻底改变了传统的LLM模式,允许我们在本地电脑上部署类似于ChatGPT的大型语言模型,解决了网络和对话次数限制的问题。然而,如果希望随时随地使用DeepSeek云服务,可以考虑利用php中文网的HAI或TI平台。

PHP中文网的TI平台是一款为AI工程师设计的一站式机器学习平台,能够快速帮助用户实现模型训练、评估和部署。作为新兴的大模型,DeepSeek同样可以在TI平台上一键式部署。

PHP中文网的TI平台是一款为AI工程师设计的一站式机器学习平台,能够快速帮助用户实现模型训练、评估和部署。作为新兴的大模型,DeepSeek同样可以在TI平台上一键式部署。

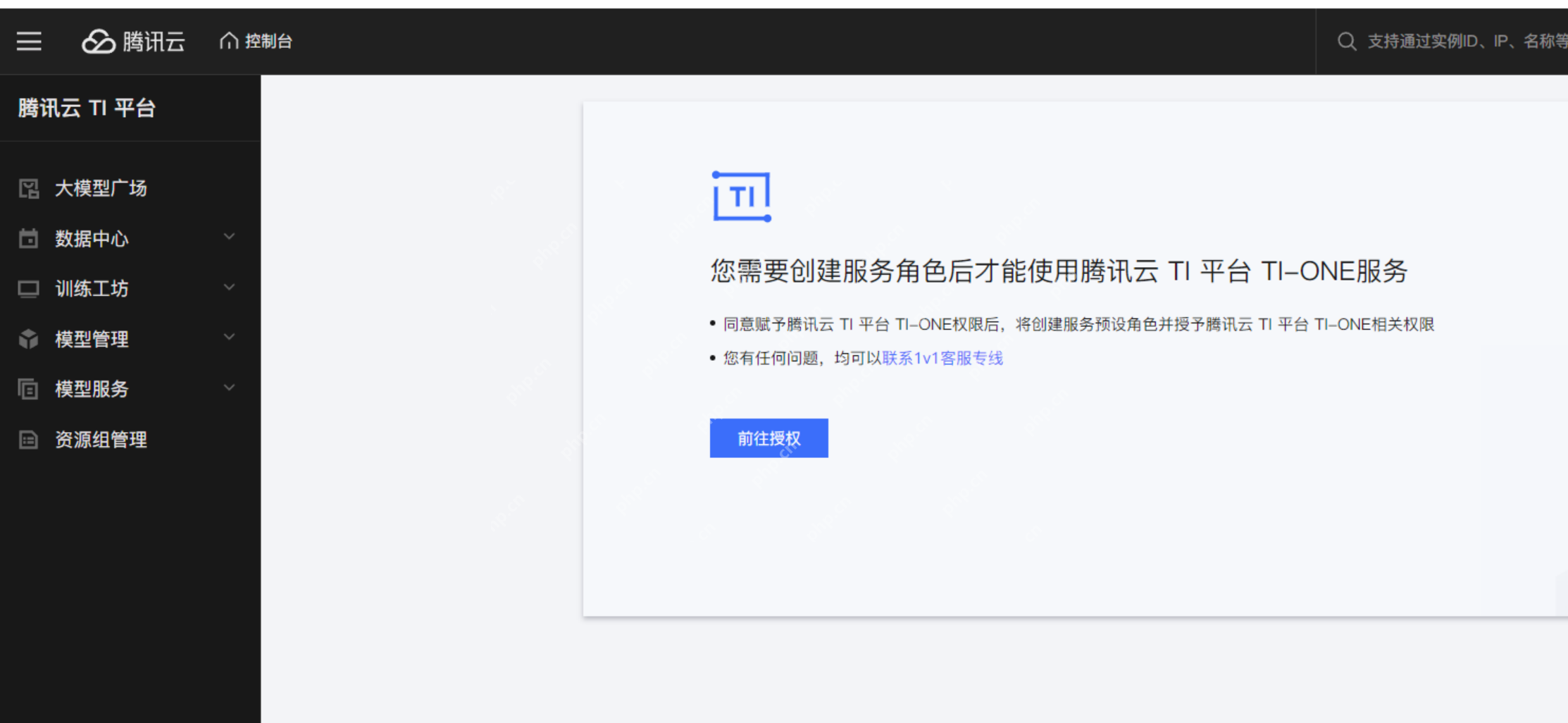

首次登录PHP中文网TI平台时,需要创建服务角色,按照流程完成授权后,即可进入TI平台的大模型广场。

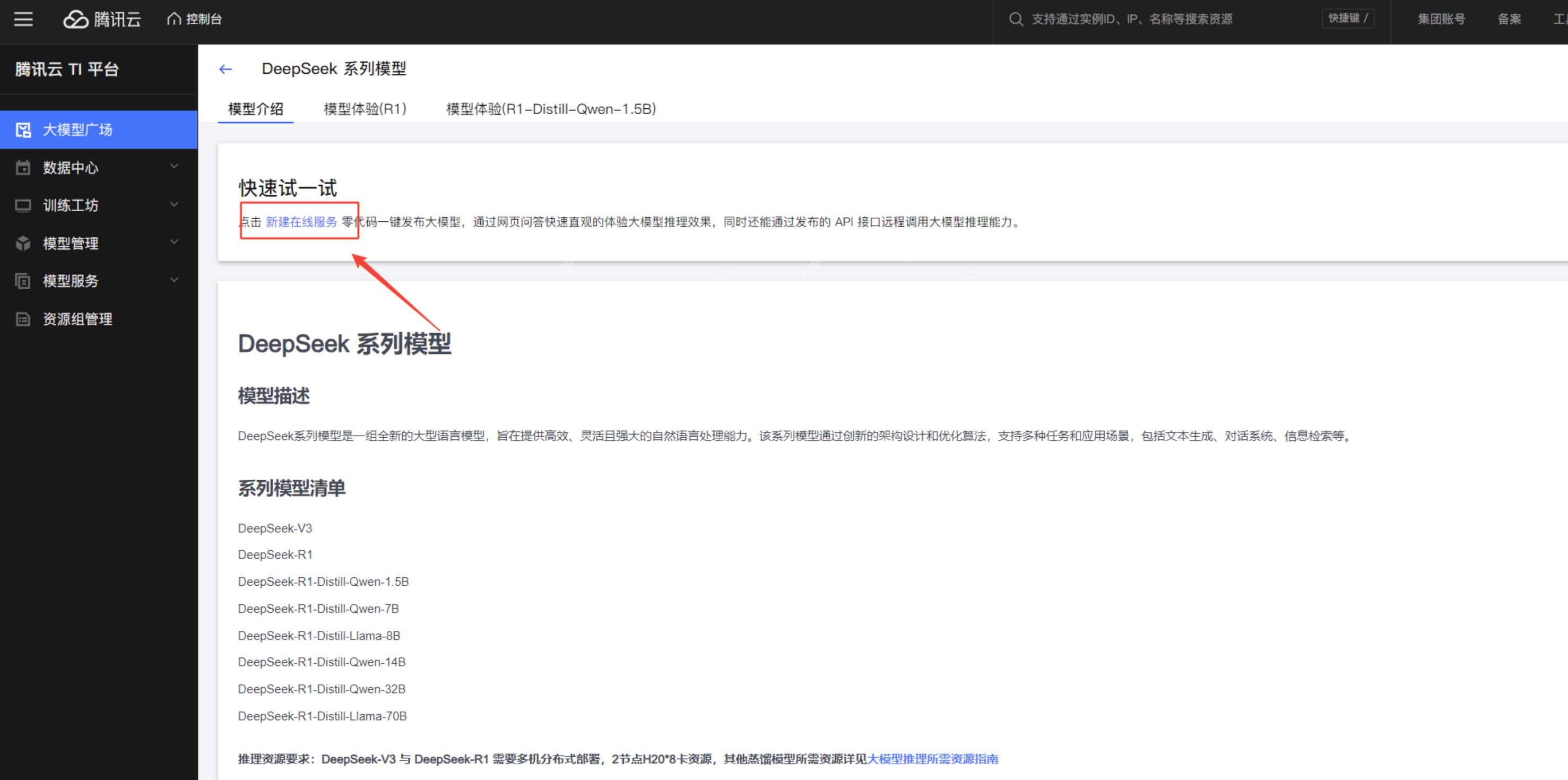

大模型广场是TI平台内置的大模型库,包含多种预训练和指令微调的大模型,适用于多轮对话、逻辑推理、内容创作等任务。在这里,我们可以找到DeepSeek系列模型。

大模型广场是TI平台内置的大模型库,包含多种预训练和指令微调的大模型,适用于多轮对话、逻辑推理、内容创作等任务。在这里,我们可以找到DeepSeek系列模型。

点击进入DeepSeek的详情页面,可以查看模型介绍和体验模型。

点击进入DeepSeek的详情页面,可以查看模型介绍和体验模型。

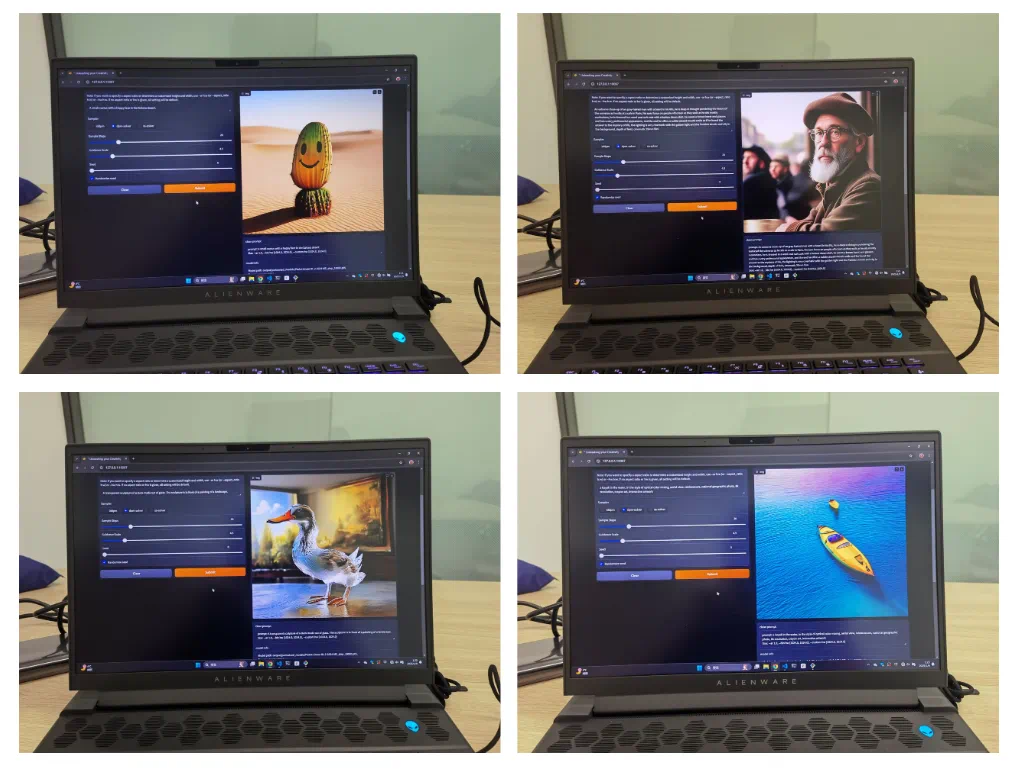

在模型体验部分,可以与DeepSeek模型进行对话。

在模型体验部分,可以与DeepSeek模型进行对话。

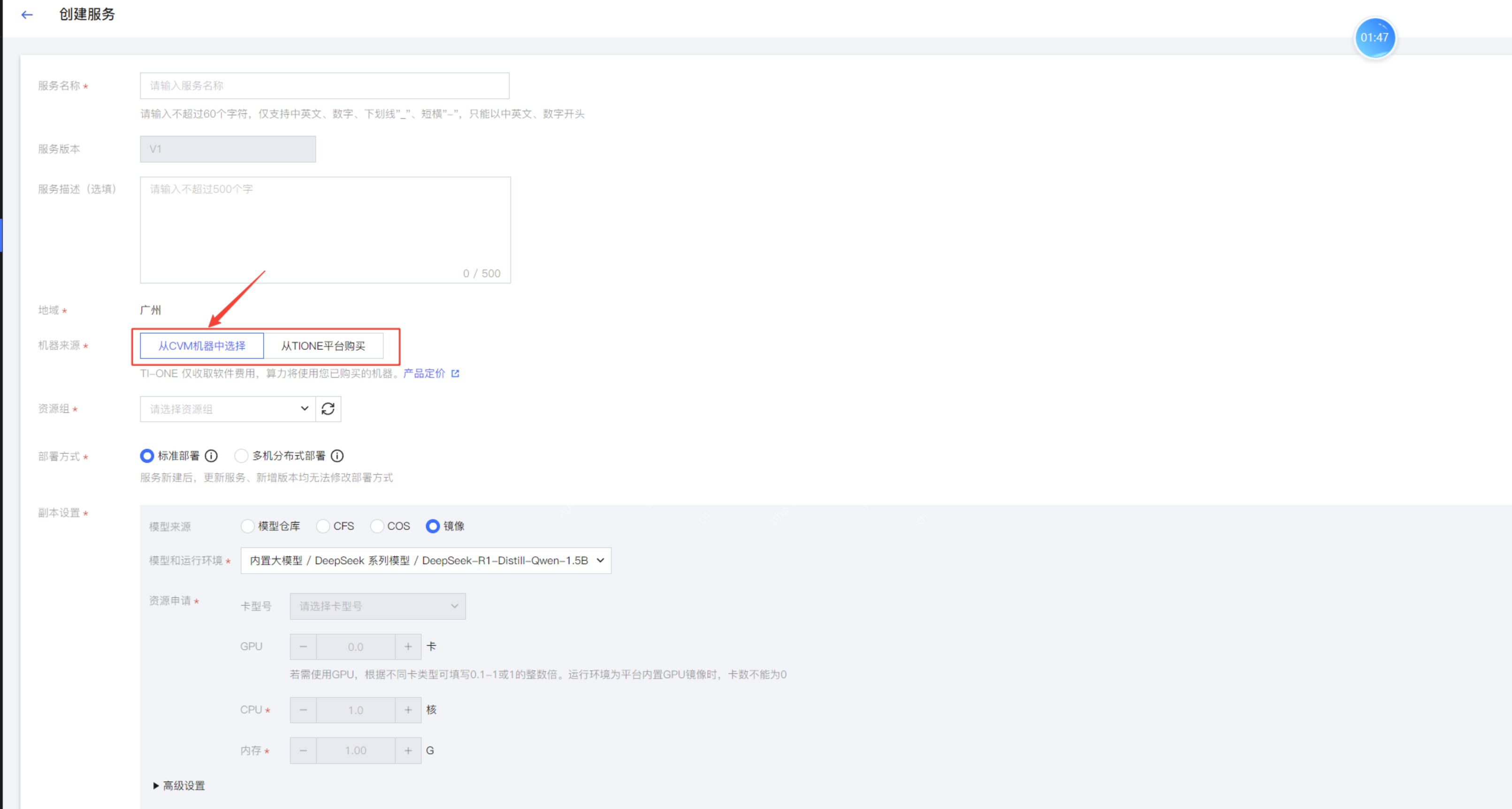

创建在线服务在DeepSeek的模型页面,点击新建在线服务,进入服务创建页面。填写服务名称后,选择用于部署DeepSeek的机器资源。

创建在线服务在DeepSeek的模型页面,点击新建在线服务,进入服务创建页面。填写服务名称后,选择用于部署DeepSeek的机器资源。

使用自有CVM可能面临资源不足的风险,通常带有显卡的CVM价格较高,且无法在资源不足时调整显卡内存或内存大小。TIONE平台支持按量计费,可以实现快速扩容和缩容。

使用自有CVM可能面临资源不足的风险,通常带有显卡的CVM价格较高,且无法在资源不足时调整显卡内存或内存大小。TIONE平台支持按量计费,可以实现快速扩容和缩容。

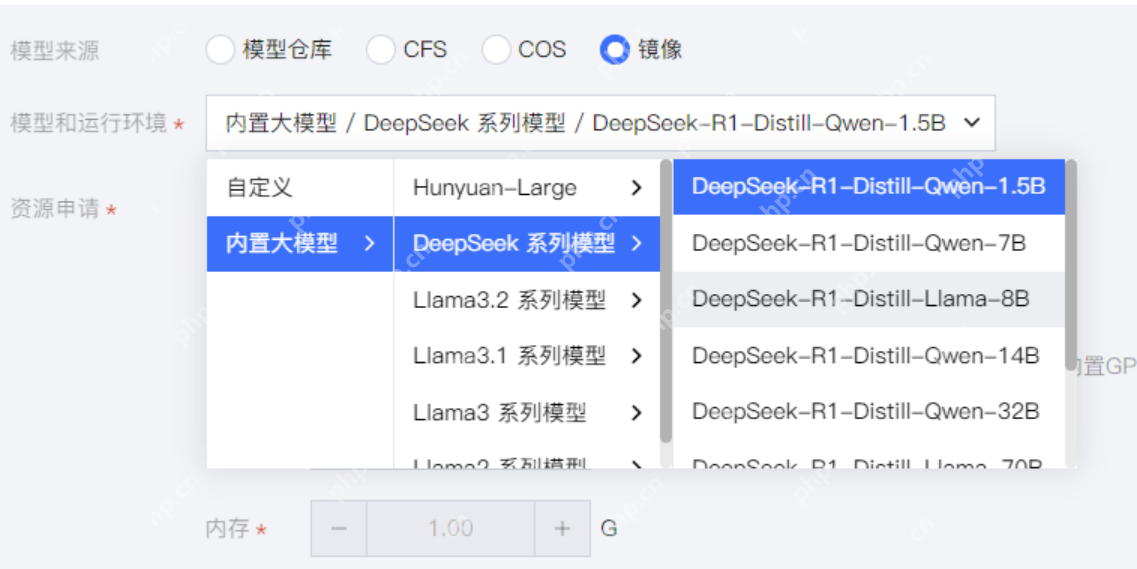

在内置大模型中,可以看到不同名称的DeepSeek大模型,各模型的区别如下:

在内置大模型中,可以看到不同名称的DeepSeek大模型,各模型的区别如下:

Qwen系列(通义千问):基于阿里巴巴的Qwen系列,适用于中文任务,具有强大的知识推理和上下文理解能力。LLaMA系列:基于Meta的LLaMA(LLaMA2/3),适用于多语言任务,在英文任务上表现出色。DeepSeek自研模型(R1/V3):DeepSeek自主训练的大规模Transformer模型,R1主要用于推理,V3可能结合更多创新结构。

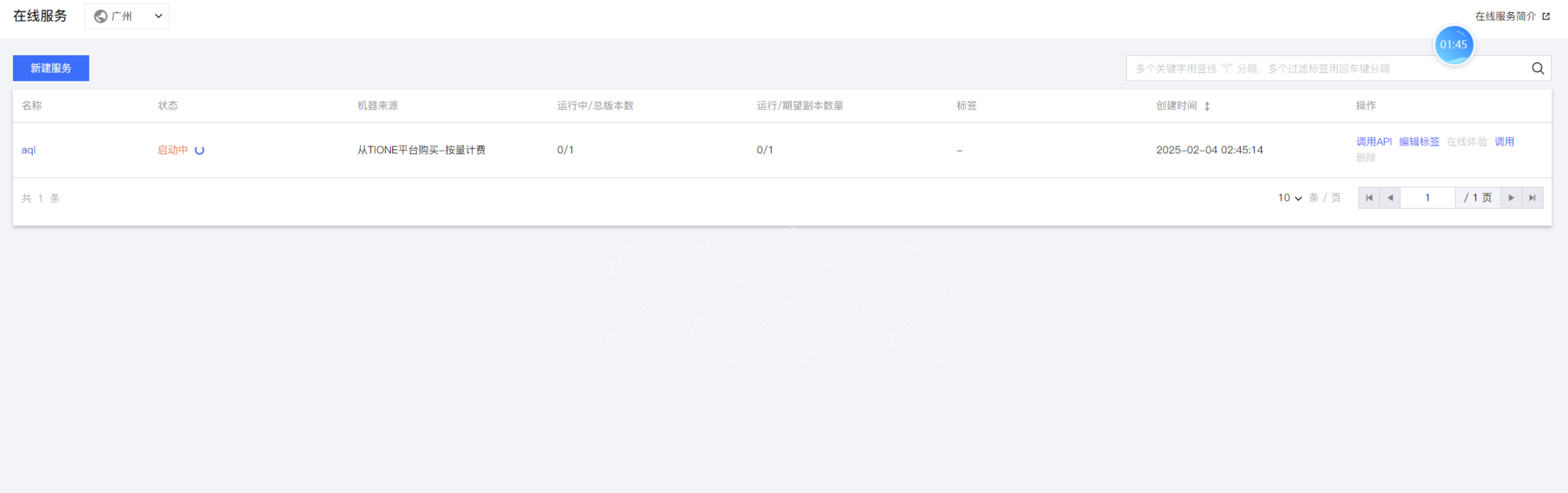

选择算力规格由于没有CVM,我选择从TIONE平台购买算力,采用按量计费的方式。 根据选择的DeepSeek模型,选择相应的算力规格,点击启动服务。

根据选择的DeepSeek模型,选择相应的算力规格,点击启动服务。

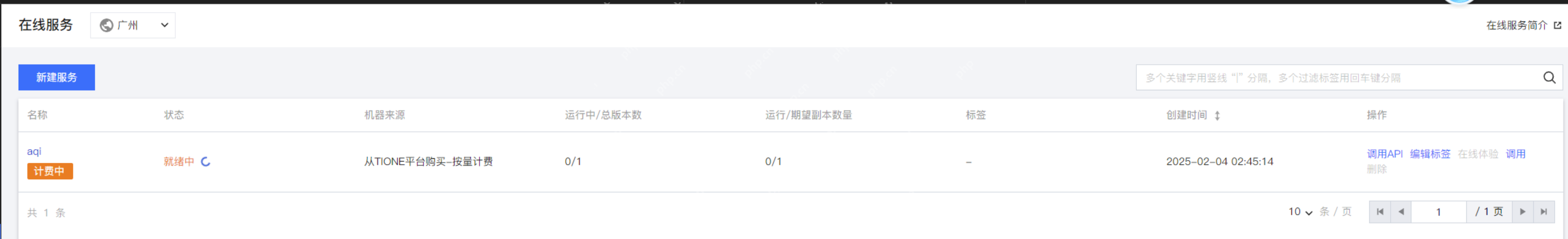

等待服务就绪后,点击服务查看详情。

等待服务就绪后,点击服务查看详情。

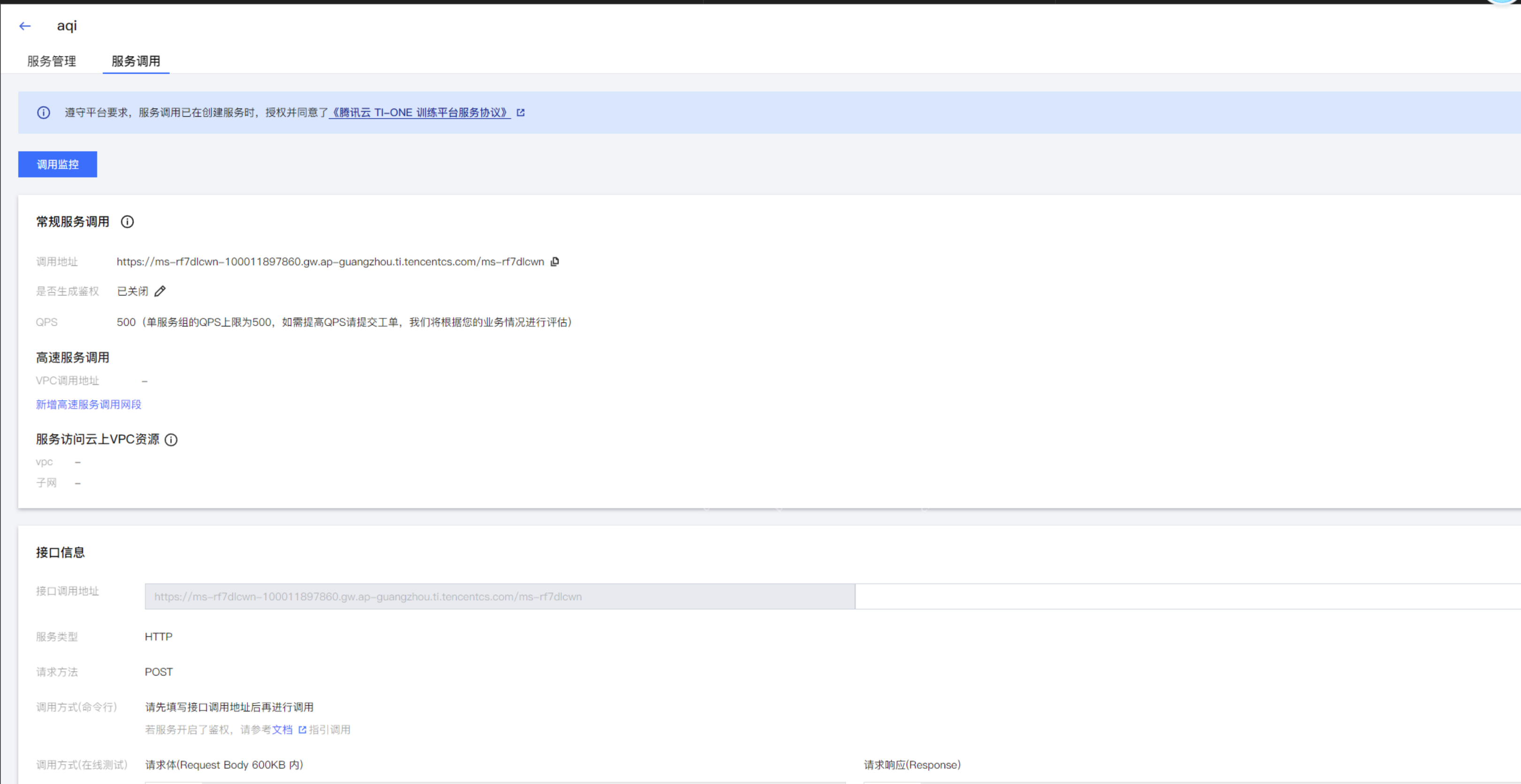

点击调用API,可以查看DeepSeek的服务调用地址。

点击调用API,可以查看DeepSeek的服务调用地址。

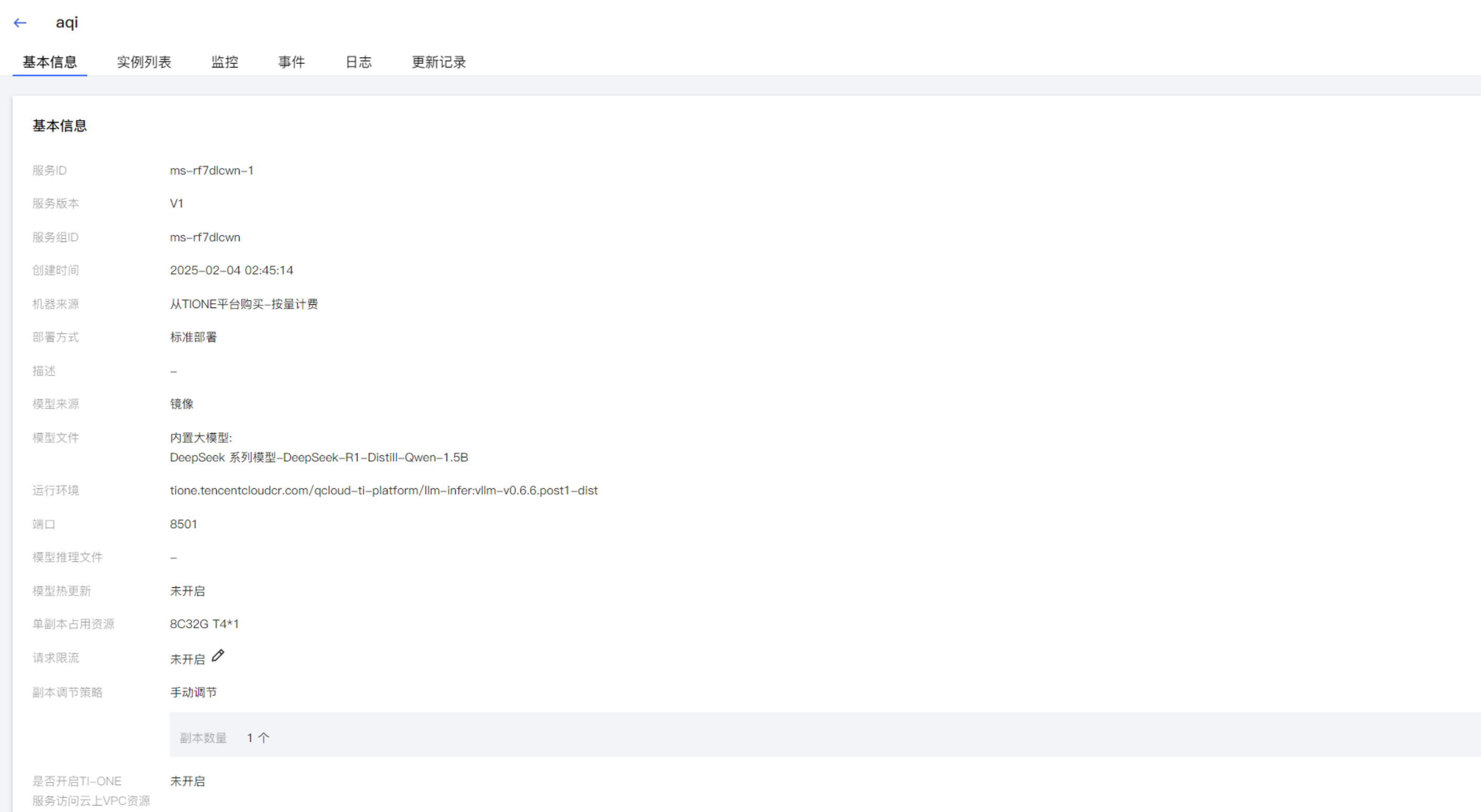

同时点击实例进入详情页面,可以看到安装了DeepSeek大模型实例的信息。

同时点击实例进入详情页面,可以看到安装了DeepSeek大模型实例的信息。

至此,我们完成了DeepSeek在PHP中文网TI平台的部署。

至此,我们完成了DeepSeek在PHP中文网TI平台的部署。

结语通过PHP中文网的TI平台,我们无需自己部署DeepSeek大模型运行环境,也无需购买服务器,通过资源打包和按量计费的方式,通过简单的界面化配置,即可完成DeepSeek的部署。

以上就是腾讯云TI平台极速部署DeepSeek的详细内容,更多请关注其它相关文章!

" alt="行业首批!腾讯云TI平台支持DeepSeek全系模型精调与推理">

" alt="行业首批!腾讯云TI平台支持DeepSeek全系模型精调与推理">