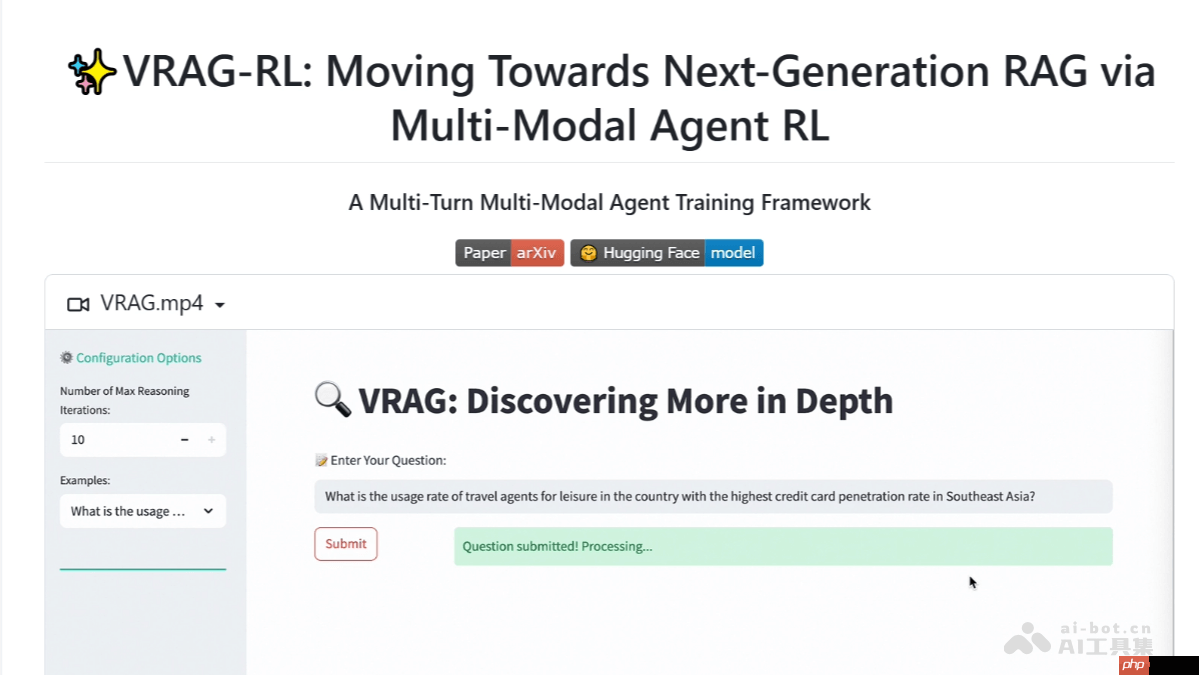

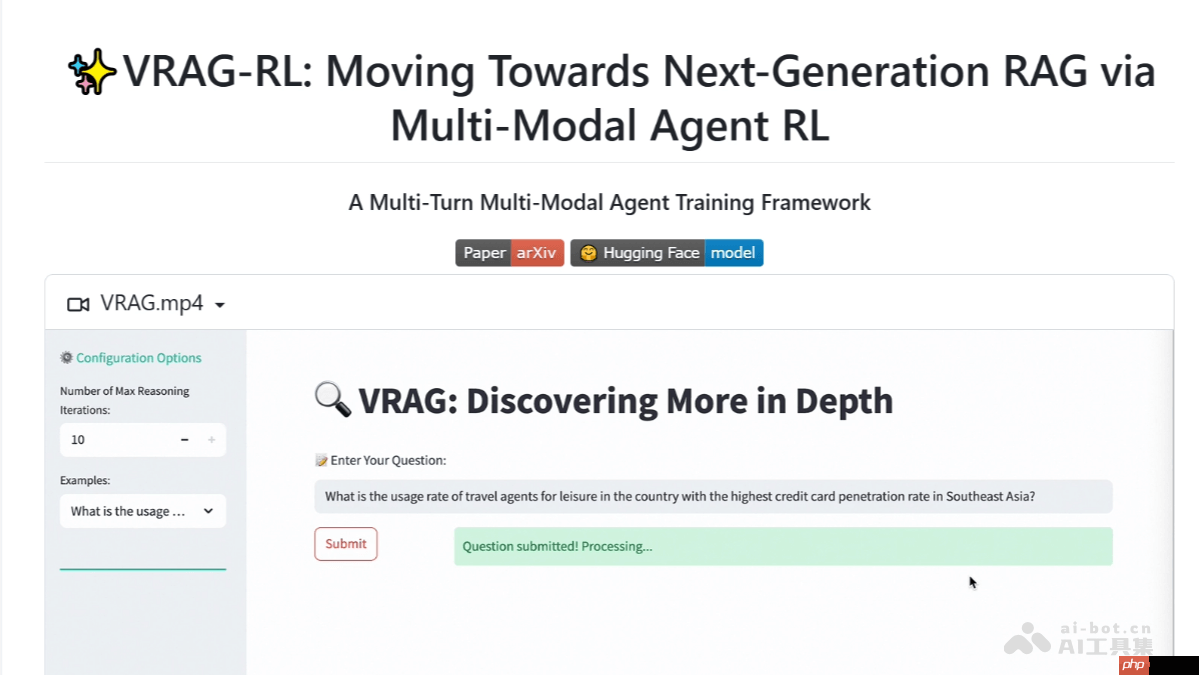

在人工智能的广阔领域内,阿里巴巴达摩院近日隆重推出了一个创新性技术成果——VRAG-RL,这是一套革命性的多模态推理框架。该框架标志着在融合视觉、语言与强化学习方面迈出了重要一步,为AI系统赋予了更强大的理解和决策能力。VRAG-RL旨在通过整合多样化数据形态,利用深度学习与强化学习的协同效应,解决复杂场景下的语义理解与自适应决策问题。它不仅提升了AI对于复杂任务的处理效率,还能在无明确指令环境下,自主学习并优化其行为策略,开启了一扇通往更高智能层次的大门。在教育、医疗、智慧城市等众多领域,VRAG-RL的应用前景令人期待,预示着定制化、智能化解决方案的新纪元。

VRAG-RL是什么

vrag-rl是由阿里巴巴通义大模型团队开发的一种视觉感知引导的多模态rag推理框架,致力于提高视觉语言模型(vlms)在处理包含丰富视觉信息任务中的检索、推理及理解性能。该框架通过定义视觉感知的动作空间,使模型能够从宏观到微观逐步提取信息,从而更高效地激发其推理潜能。vrag-rl采用综合奖励机制,融合检索效率与模型生成结果的双重考量,进一步优化模型的检索与生成表现。在多项基准测试中,vrag-rl的表现远超现有技术方案,展现出其在视觉信息解析领域的卓越实力。

VRAG-RL的核心功能

VRAG-RL的核心功能

视觉感知强化:借助预先设定的视觉感知操作(如区域选取、图像裁剪及尺寸调整),促使模型按层次化方式捕获细节,从而更加精准地调动推理潜能。

多轮对话式推理:具备多轮连续对话的能力,允许模型与

搜索系统反复沟通,持续改进推理流程。

复合奖励体系:整合检索效能与模型产出质量的奖励标准,全方位指引模型改进推理及检索技巧,使其更贴合实际使用情境。

模块化兼容性:框架

设计灵活,便于整合各类工具及模型,方便用户依据需求进行个性化定制与功能拓展。

VRAG-RL的技术架构

视觉感知行为域:确立一系列视觉感知行为规范,涵盖目标区域锁定、裁切以及缩放等步骤,助力模型分阶段深入挖掘关键数据点。

强化学习架构:运用强化学习(RL)手段精进模型的推理与检索水准。模型依据与搜索引擎的实际互动情况,自主

采集单轮或多轮推理路径,并据此循环优化。

复合激励准则:构建一套综合评分体系,涵盖检索效率加分项、模式匹配度加成以及基于模型反馈的成效评估,着重于最终成果的质量,优化整个检索程序。

多轮迭代训练:依托多轮迭代训练策略,在模型与外界环境的持续交互过程中稳步提升推理品质,保证推理过程的可靠性和连贯性。

数据扩充与预训:利用多专家样本采集法扩展训练集规模,确保模型在前期训练阶段充分吸收视觉感知与逻辑推理方面的宝贵经验。

VRAG-RL的资源链接

GitHub代码库:

HuggingFace模型库:

学术

论文预览:

VRAG-RL的实际应用

智慧文档查询:迅速筛选并解读PPT、报告等形式的文件资料,精准回应各类提问。

视觉数据检索:从海量图表、

照片中快速识别并摘录相关的视觉元素。

跨模态内容创作:结合图像与文字素材,生成图文兼备的专业摘要或汇报文档。

教育辅助服务:为师生提供支持,协助理解复杂视觉材料。

客户服务与虚拟助手:解答涉及视觉内容的客户咨询,提供精确答复。

以上就是VRAG-RL—阿里通义推出的多模态RAG推理框架的详细内容,更多请关注其它相关文章!

VRAG-RL的核心功能

VRAG-RL的核心功能