时间:2025-03-04 关注公众号 来源:onlinedown

本文将详尽阐述如何在本地执行DeepSeek模型的部署流程,并配以图像和文字说明,确保初级学习者也能够轻松上手。我们将逐一解析从环境配置、依赖项安装、模型下载直至模型运行的每个具体环节。

一、本地部署适用的情况包括:

1. 您的计算机配置较高,拥有独立显卡:本地部署需要强大的硬件支撑,特别是对于GPU的需求更为显著。

2. 您需要处理涉及敏感信息的数据,担忧数据泄漏:本地部署能避免数据上传至云端,从而保障数据安全。

3. 在日常工作中需要与本地应用相结合:面对高频率或者复杂的任务时,本地部署可提供更高的灵活性与效率。

4. 对于大量日常使用的场景,调用API接口需付费:本地部署则能节省API调用的成本。

5. 如果您希望基于开源模型进行个性化的定制:本地部署则允许您对模型进行二次开发及自定义。

总结而言,具备经济和技术实力且注重隐私保护的情况下,应考虑本地部署;反之,若追求简便省事,可以选择直接使用网络或移动应用程序。

二、本地部署的操作步骤:

1. 环境准备:请确保您的系统满足如下要求:

- 操作系统:推荐使用Ubuntu 20.04及以上版本或windows系统。

- Python:需要Python 3.8或更高版本。

- GPU:支持CUDA的NVIDIA GPU,推荐使用16GB内存以上的型号。

- CUDA:需要11.2或更高版本。

- CUDNN:需8.1或更高版本。

- 对于Linux用户,请按照指示操作;而对于Windows用户,请根据个人电脑类型选择相应版本。

2. 安装依赖项:首先执行以下命令以安装必需的依赖项:

...

3. 创建虚拟环境:为了防止依赖冲突,建议在虚拟环境中进行操作:

...

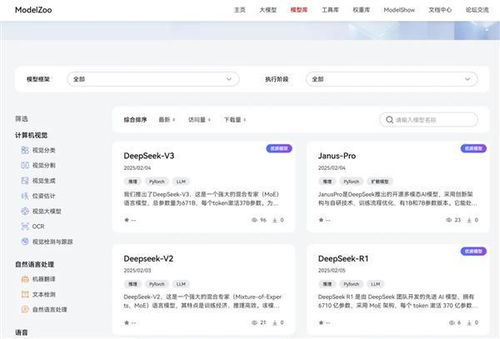

4. 至12. 部署模型(可选),分别涵盖安装PyTorch、克隆DeepSeek代码仓库、安装项目依赖项、下载预训练模型、配置环境变量、运行模型以及可选的训练和部署模型等步骤。

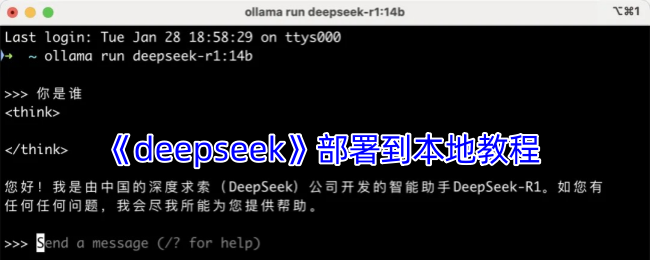

5. 若觉得上述手动部署步骤复杂,您可以尝试使用Ollama工具简化本地部署流程。Ollama是一款针对AI模型管理而设计的工具,尤其适合新手用户。

1. 安装Ollama:

...

2. 选择并安装模型:

...

3. 与模型进行对话:

...

后续运行模型操作提示:

...

四、(可选)安装Open-WebUI:

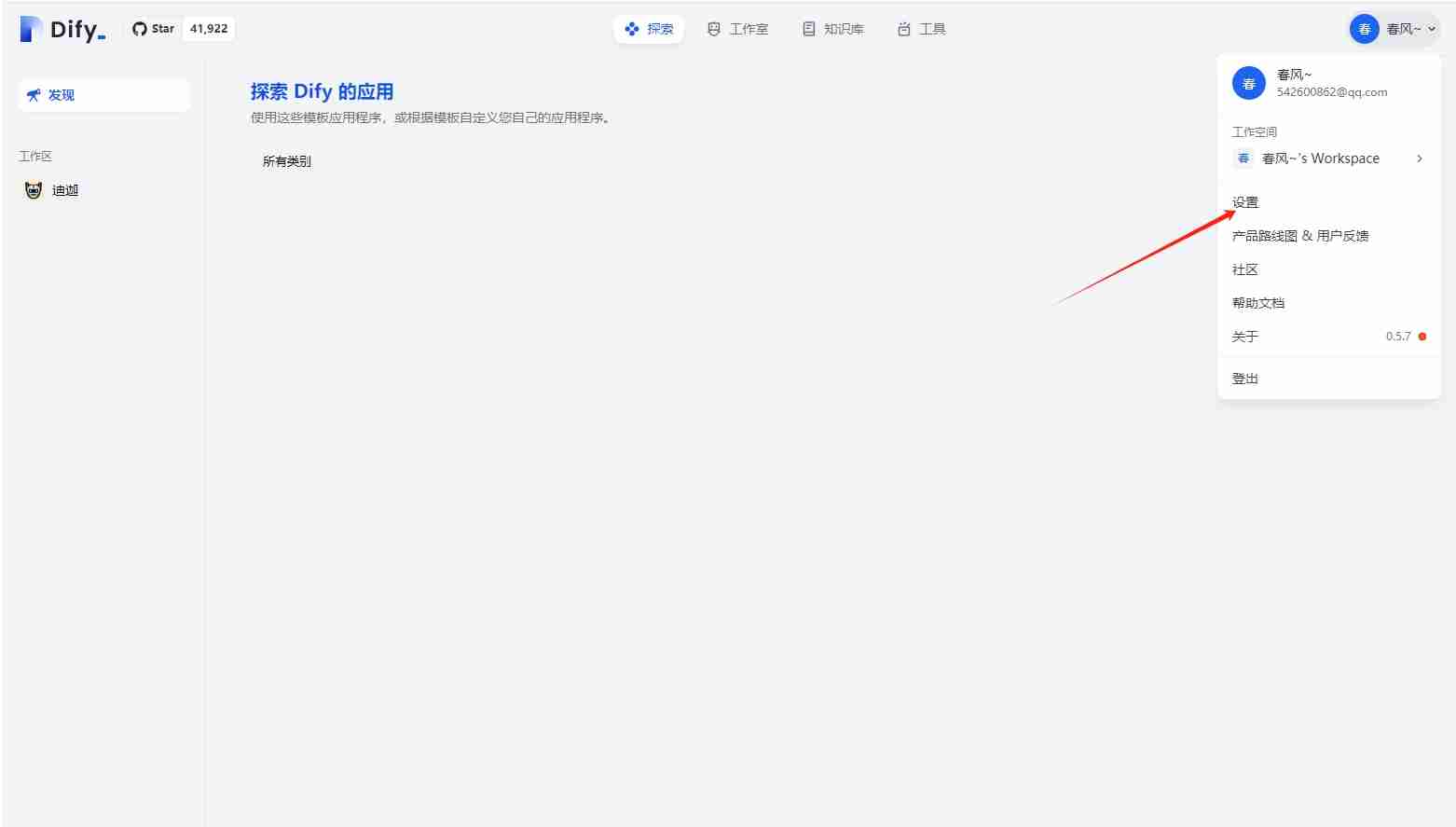

Open-WebUI可以为Ollama提供一个更加直观的图形界面,但对于技术基础较弱的用户来说,安装过程可能较为复杂(仅为提升交互界面美观度,非必要选项)。这里仅简单演示说明:

1. 安装Docker:

...

2. 安装Open-WebUI:

...

Windows系统下的操作与上述类似。

五、常见问题解答:

1. 如何查看已安装的模型?

...

2. 如何删除模型?

...

3. Ollama其他功能:

...

六、结论:

通过上述方法,无论是采用手动安装还是借助Ollama工具,您都能够便捷地在本地实现DeepSeek模型的部署。本地部署不仅能为您提供更高的灵活性与数据安全性,还能更好地适应各种应用场景。