时间:2025-05-16 关注公众号 来源:网络

在人工智能领域的新一轮探索中,腾讯与京东强强联合,会同多家顶尖高校的智慧力量,共同推出了一项革命性的技术成果——“灵动创界”。这一创新框架旨在突破传统界限,实现跨模态的动态内容生成,涵盖了图像、视频、语音等多个维度。它不仅是技术合作的典范,更是学术与产业深度融合的结晶。通过深度学习与多模态融合算法的精妙结合,“灵动创界”能够以前所未有的灵活性和创造力,为用户和开发者提供一个全新的动态内容创作平台,开启了数字世界表达与互动的新篇章。这项技术的问世,预示着未来在媒体、娱乐、教育等诸多领域的应用将更加丰富多样,极大地推动了内容生成技术的边界,引领着我们步入一个更加生动、互动的数字时代。

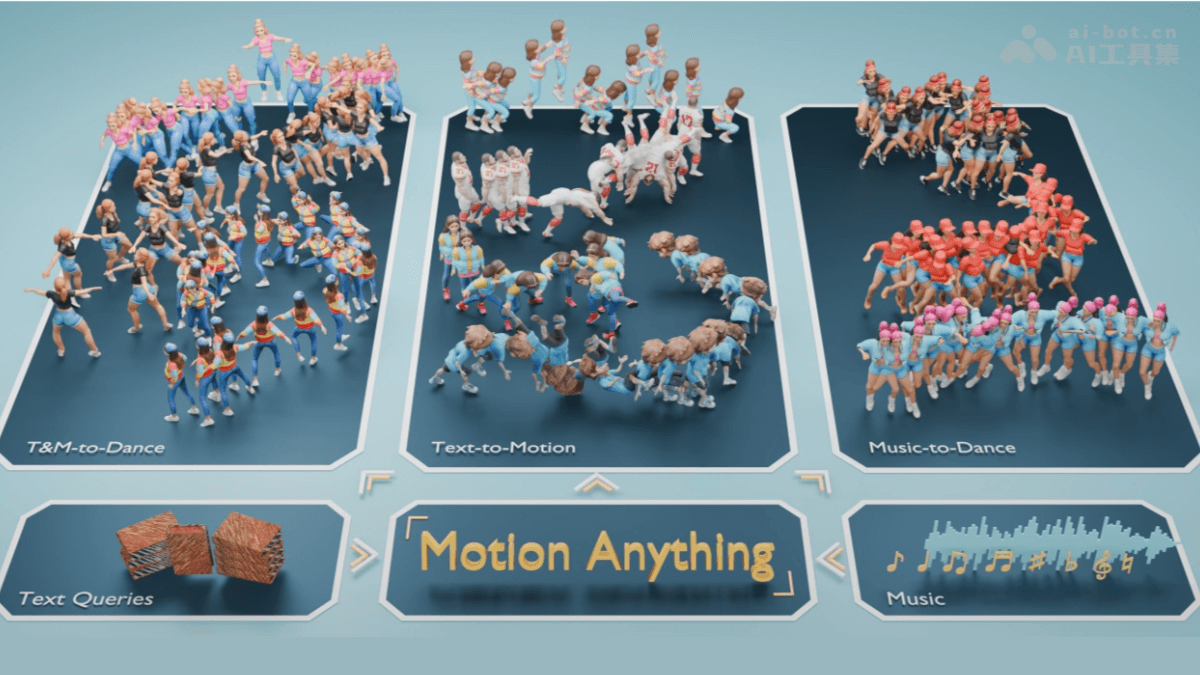

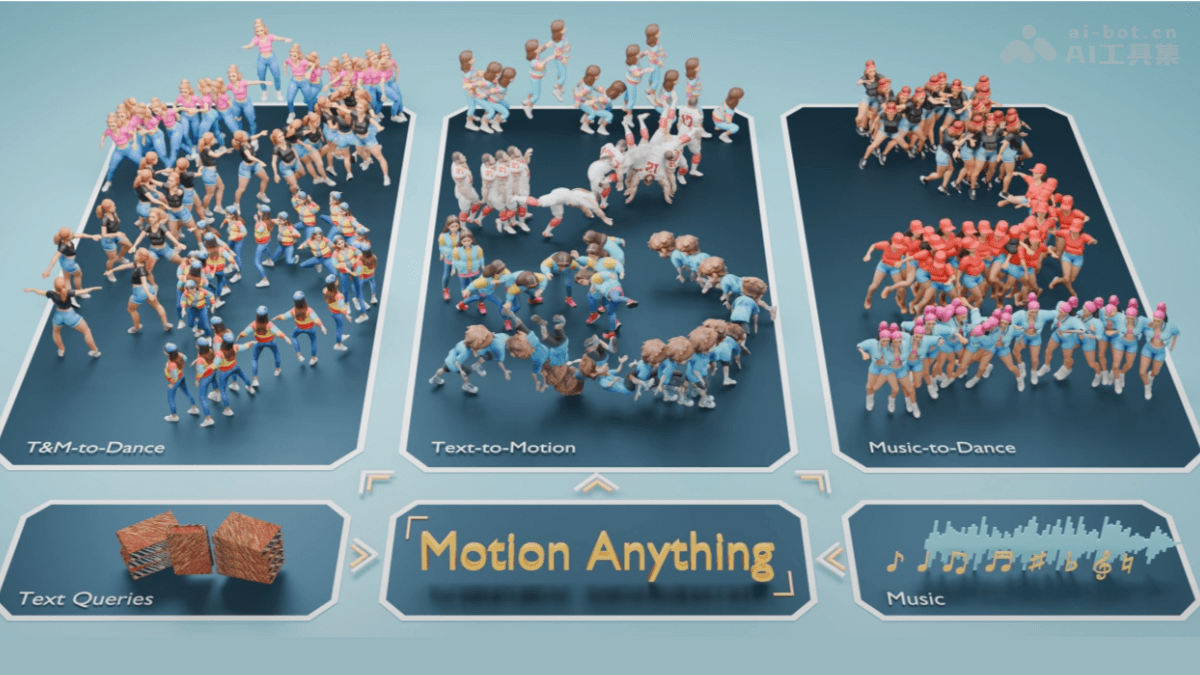

motionanything:多模态运动生成框架

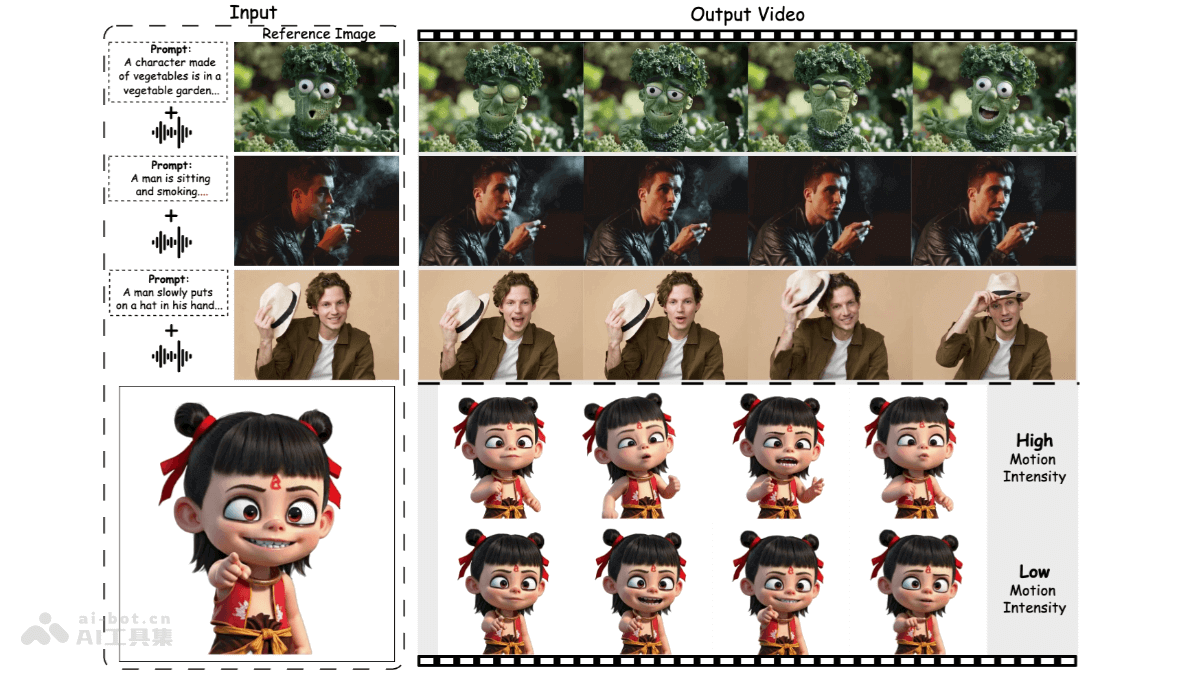

MotionAnything是由澳大利亚国立大学、悉尼大学、腾讯、麦吉尔大学和京东等机构联合推出的一个先进的多模态运动生成框架。它能够根据文本描述、音乐,或两者结合,生成高质量、可控的人类运动。该框架解决了现有方法在根据条件优先生成动态内容方面的不足。

核心功能:

多模态驱动:支持文本、音乐或文本音乐组合作为输入,生成相应的运动。 精准控制:基于注意力机制,实现对关键帧和动作的细粒度控制,确保生成结果的准确性。 动态优先:优先生成与输入条件(文本或音乐)最相关的动态部分。 跨模态对齐:在时间和空间维度上对齐文本、音乐和运动,保证生成运动的连贯性和一致性。技术原理:

MotionAnything的核心技术包括:基于注意力的掩码建模、时间自适应变换器和空间对齐变换器。通过这些技术,框架能够有效整合多模态信息,并实现动态内容的优先生成和跨模态对齐。此外,它还采用了多模态条件编码,将不同模态的信息融合到运动生成过程中。

基于注意力的掩码建模:选择与输入条件最相关的运动部分进行掩码,优先恢复关键帧和动作。 时间自适应变换器:根据输入条件动态调整注意力计算,确保运动与文本关键词或音乐节拍对齐。 空间对齐变换器:重新排列条件和运动嵌入,保证运动与条件在空间上的一致性。 多模态条件编码:融合文本和音乐等多种模态信息,提升生成效果。数据支持:

MotionAnything使用了新的Text-Music-Dance(TMD)数据集,包含2153个文本、音乐和舞蹈配对样本,为多模态运动生成研究提供了新的基准。

应用场景:

MotionAnything在多个领域具有广泛的应用前景,例如:

影视动画制作:提高效率和视觉效果。 虚拟现实/增强现实:创建更逼真的虚拟角色。 游戏开发:生成更自然流畅的角色动作。 人机交互:实现更自然的机器人动作控制。 教育和培训:提供标准动作示范。项目信息:

项目官网: GitHub仓库: arXiv论文:以上就是MotionAnything—腾讯联合京东等高校推出的多模态运动生成框架的详细内容,更多请关注其它相关文章!